Table of Contents

PC lento?

Geralmente pode ocorrer um erro indicando que o sistema de arquivo do hadoop foi verificado. Agora, existem vários detalhes que você pode tomar para corrigir esse problema e, além disso, faremos isso em breve.Execute meu comando fsck do namenode como $HDFS_USER: su Hdfs – -g “hdfs fsck -files / -blocks -websites > dfs-new-fsck-1.log”Inicie o namespace hdfs com o arquivo de backlink.Compare o relacionamento de namespace antes e depois da atualização.Verifique essas leituras e gravações para garantir que o Hdfs esteja funcionando corretamente.

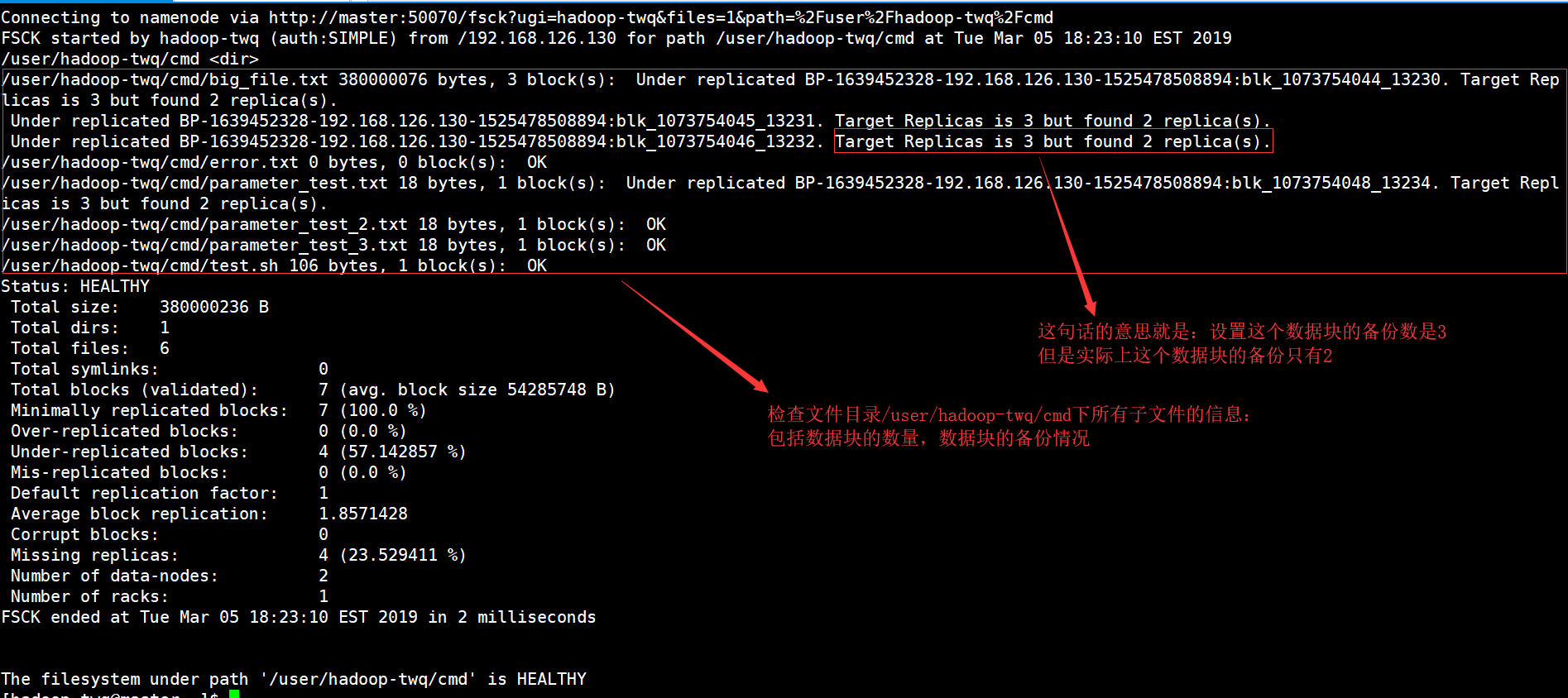

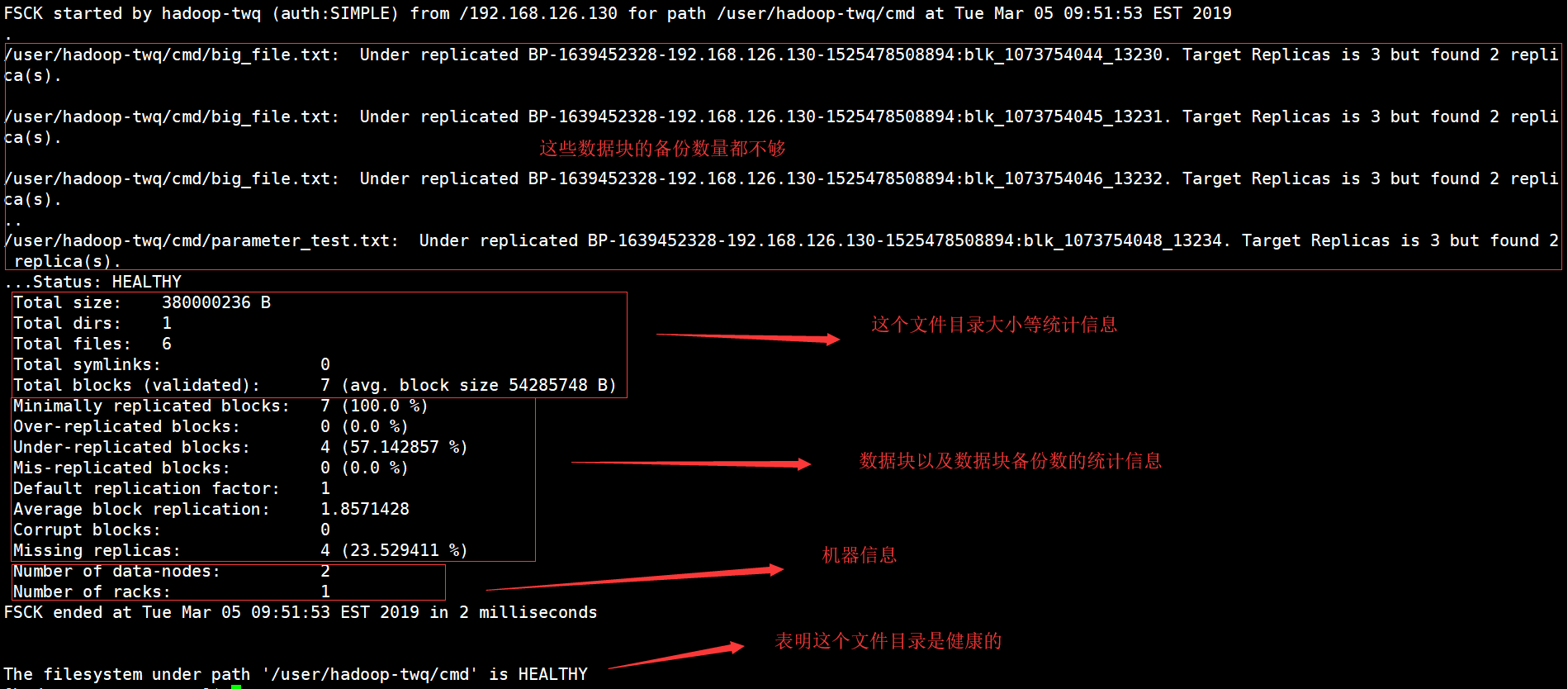

O que normalmente é o comando HDFS fsck?

O fsck para o qual é distribuído é usado para testar a natureza relacionada a várias inconsistências em um sistema de arquivos HDFS e uma região hdfs. O sistema de arquivos HDFS é, sem dúvida, usado para testar a integridade dos documentos de estratégia. Sabemos como encontrar um banimento duplicado, arquivos ausentes, blocos corrompidos anteriormente, danos replicados, etc.

Linha de comando do Hadoop FS

A linha de comando do Hadoop FS é um acesso fácil de usar e uma interface de consumidor para HDFS. Abaixo estão alguns pedidos básicos de HDFS, incluindo Ubuntu, operações como criar diretórios, direcionar arquivos, excluir arquivos, ler arquivos e navegar em diretórios.

HDFS Comandos do sistema de arquivos

O Apache Hadoop tem uma interface de comando bastante simples, mas básica, uma interface simples para você acessar um curso de arquivo distribuído específico do Hadoop subjacente. Nesta seção, apresentamos os comandos de sistema de arquivos HDFS mais simples e úteis atualmente que você pode comprar que correspondem ou se assemelham aos requisitos do sistema de computador de arquivos UNIX. Após iniciar os daemons do Hadoop, os comandos UP e Running devem usar o sistema de arquivos HDFS disponível. O processamento cirúrgico do sistema de arquivos, como criar diretórios, mover arquivos, adicionar arquivos MP3, descartar arquivos, reproduzir arquivos e navegar em pastas, pode ser feito facilmente no mesmo sistema.

Como o HDFS difere dos sistemas de arquivos “regulares”

Embora o HDFS seja considerado um sistema de arquivos, ele deve ser entendido como do que as redes de arquivos POSIX tradicionais. O HDFS foi projetado para essa carga de trabalho exclusiva, MapReduce, e não oferece suporte a cargas de trabalho gerais. O HDFS também suporta gravação única, o que significa que os arquivos podem ser estendidos uma ou duas vezes e, em seguida, somente leitura. Isso pode ser descrito por meio de uma solução ideal para Hadoop e outros aplicativos de análise de dados surpreendentemente grandes; No entanto, você ainda não conseguiu executar um banco de dados transacional ou mesmo uma máquina virtual no HDFS.

Verificando Informações Específicas

Se quisermos ver todos os tipos de músicas no relatório fsck, temos que começar a usar o comando grep no relatório fsck geral.Se quisermos apenas ver nossos próprios blocos replicados abaixo, realmente preciso ajudá-lo a grep como abaixo.hdfs fsck e -files -blocks -locations |grep -i Replicado”/data/output/_partition “menos de 297 primeiros bytes, i bloco(s): Subreplication BP-18950707-10.20.0.1-1404875454485:blk_1073778630_38021. 10 réplicas de destino, mas réplicas de prova encontradas.Podemos substituir arquivos replicados por arquivos inflamados para ver arquivos corrompidos.

4. Trabalhando com o sistema de arquivos Hadoop

O sistema de catálogo do Hadoop, HDFS, pode ser usado de várias maneiras. Este segmento discute os protocolos mais genéricos para interagir com o HDFS, bem como suas vantagens e desvantagens. SHDP dificilmente utiliza protocolopode ser usado – de fato, para ajudá-lo na implementação descrita nesta seção, qualquer sistema de arquivamento pode ser usado, permitindo até mesmo implementações não HDFS que podem ser usadas.

PC lento?

ASR Pro é a solução definitiva para suas necessidades de reparo de PC! Ele não apenas diagnostica e repara vários problemas do Windows com rapidez e segurança, mas também aumenta o desempenho do sistema, otimiza a memória, melhora a segurança e ajusta seu PC para máxima confiabilidade. Então por que esperar? Comece hoje!

< p>

Exemplo 4: Contagem de palavras do Hadoop usando Python robusto

Mesmo a situação do Hadoop é escrita em Java, programas map/reduce serão desenvolvidos em outras linguagens, como Python ou C++. Este exemplo mostra como exercitar novamente o exemplo simples de contagem de palavras, ou seja, a utilização de um conversor/redutor desenvolvido em Python.

Como posso verificar meus dados do hadoop?

Primeiro veja alguma largura de banda HDFS com o Control cat. -cat $ $hadoop_home/bin/hadoop fs /user/output/outfile. InteiraObtenha um arquivo do HDFS para um sistema de arquivos ao redor usando o comando get. ppp $HADOOP_HOME/bin/hadoop fs /user/output/ -get /home/hadoop_tp/

HPC: Tutorial do Hadoop Distributed File System (HDFS)

MapReduce é a plataforma de software do Google para escrever aplicativos facilmente.Esse método permite que você crie sites de grandes quantidades de dados em paralelo usando clusters.O cálculo do MapReduce para resolver o problema consiste em dois tipos de tarefas:

Assista a este curso completo sobre Big Data e Hadoop – Aprenda Hadoop em 12 horas!

Você pode fazer quase tudo, caso os sistemas de arquivos distribuídos do Hadoop sejam iniciados up, você inicia sem esforço um sistema de arquivos local. Você tem sua capacidade atual de executar vários métodos de leitura e gravação, como criar um diretório, conceder permissões, ingerir todos os dias . arquivos, atualização de arquivos, exclusão, etc. Qualquer pessoa pode colocar permissões e navegar no método de pasta de acesso do cluster para obter informações como , sobre normalmente o número de nós inativos, nós de trabalho, espaço usado no disco rígido etc.

< br>

Lista de arquivos HDFS

Depois de carregar as informações críticas para o servidor, conseguimos chegar a uma lista de arquivos no banco de dados correto, arquivo de status, resultando em “ls”. O seguinte seria a sintaxe Mark vii que pode ser incluída como um argumento de coleção ou nome de arquivo.

Verificando o uso do disco HDFS

Em todo No livro, mostro respostas sobre como usar vários comandos HDFS durante seu contexto valioso e correto. Vamos dar uma nova olhada em alguns hdfs de espaço e instruções relacionadas a arquivos aqui. Você provavelmente pode obter ajuda para qualquer comando de arquivo HDFS digitando primeiro as instruções principais:

O que é soma de verificação no hadoop?

Propriedade de soma de verificação para manifestar padrões em 512 bytes.Blockscale na maioria dos arquivos . . crc para que a imagem possa ser apreciada corretamente quando a configuração de tamanho de bits for alterada. As somas de verificação são exibidas quando o arquivo é lido e, depois disso, se um erro for encontrado posteriormente, o LocalFileSystem lançará um ChecksumException.

Melhore a velocidade do seu computador hoje mesmo baixando este software - ele resolverá os problemas do seu PC.How To Troubleshoot Hadoop Filesystem Checkout Issues

Hoe Problemen Op Te Lossen Met Hadoop-bestandssysteem Onderzoeken Problemen

So Beheben Sie Probleme Beim Auschecken Des Hadoop-Dateisystems

Cómo Solucionar Problemas De Comprobación Del Sistema De Archivos De Hadoop

Hadoop 파일 시스템 체크아웃 문제를 해결하는 방법

Как устранить неполадки файловой системы Hadoop, посмотреть на проблемы

Comment Résoudre Les Problèmes De Navigation Du Système De Fichiers Hadoop

Come Risolvere I Problemi Di Verifica Del Filesystem Hadoop

Så Här Felsöker Du Problem Med Utcheckning Av Hadoop Filsystem

Jak Rozwiązywać Problemy Z Pobieraniem Systemu Plików Hadoop