Table of Contents

PC werkt traag?

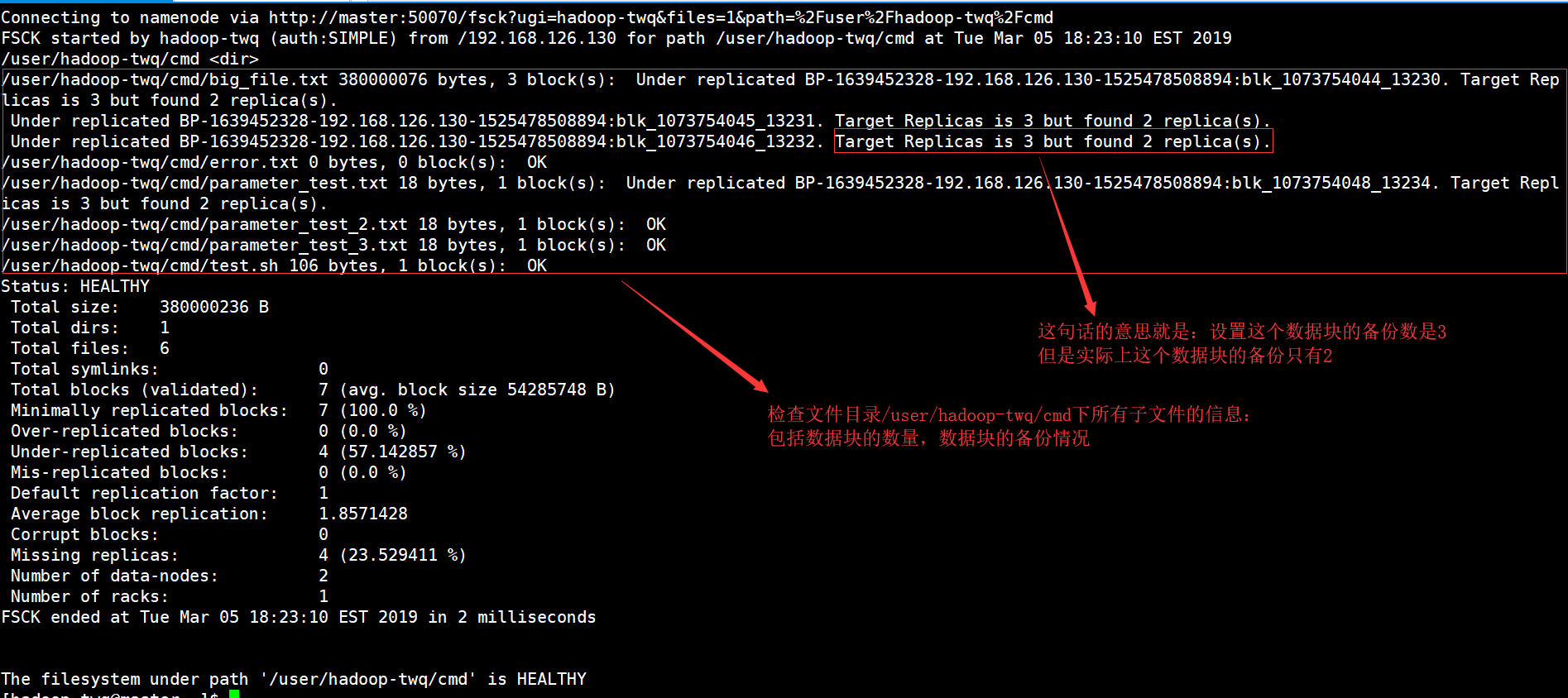

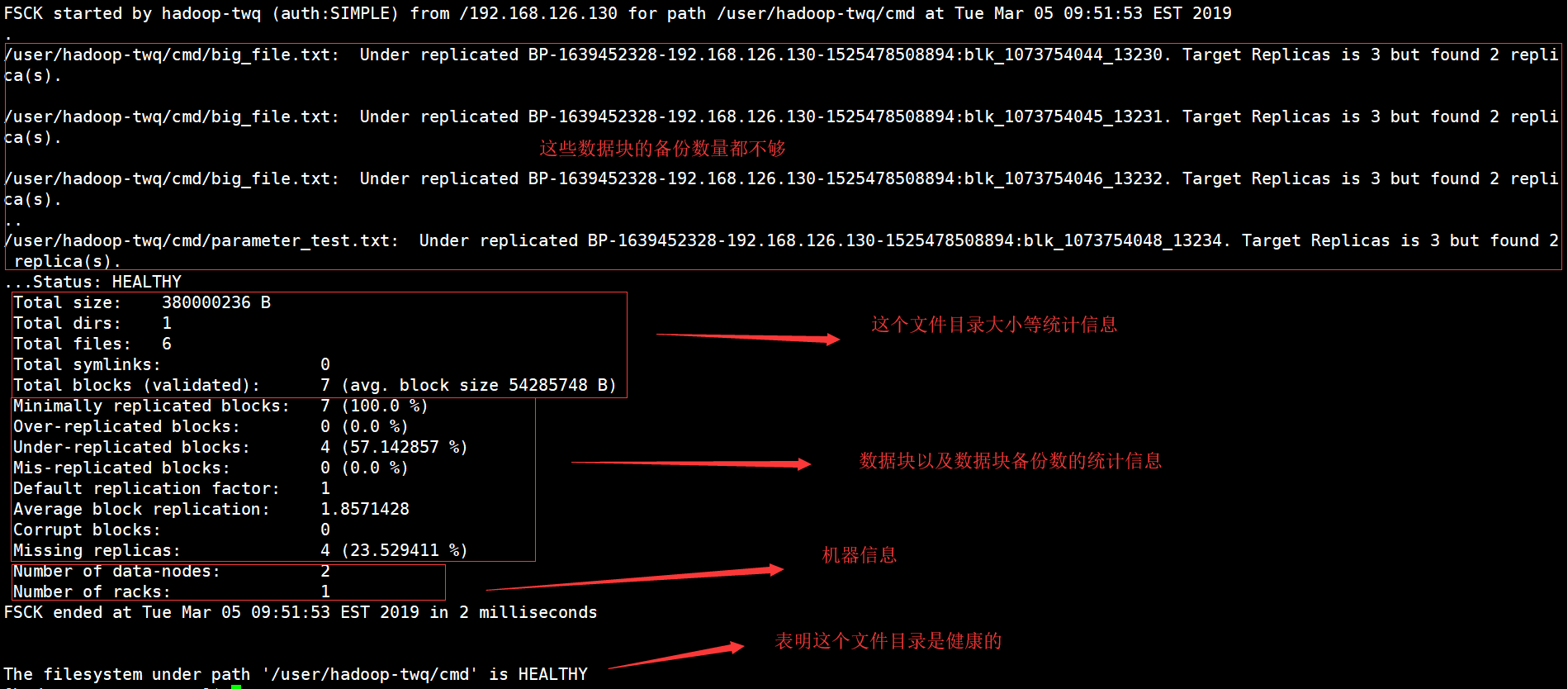

Er kan een fout optreden die aangeeft dat de weergave van het hadoop-bestandssysteem is geverifieerd. Nu zijn er verschillende stappen die iedereen kan nemen om dit probleem op te lossen en dat zullen we binnenkort doen.Voer de fsck-instructie uit vanaf namenode als $HDFS_USER: su Hdfs – -d “hdfs fsck -files / -blocks -websites > dfs-new-fsck-1.log”Start de hoofdnaamruimte hdfs met het linkbestand.Vergelijk alle naamruimterelaties voor en na de update.Controleer dezelfde lees- en schrijfbewerkingen om er zeker van te zijn dat Hdfs correct kan werken.

Wat moet de opdracht HDFS fsck zijn?

De fsck waarvoor het wordt verkocht, wordt gebruikt om de aard van verschillende inconsistenties in een HDFS-bestandssysteem of een geweldige hdfs-regio te testen. Het HDFS-bestandssysteem wordt geprobeerd om de gezondheid van systeemrecords daadwerkelijk te testen. We weten hoe we een gerepliceerde balk, ontbrekende bestanden, eerder beschadigde blokken, gerepliceerd blok, enz. kunnen vinden.

Hadoop FS-opdrachtregel

Hadoop FS-opdrachtregel is ook een gemakkelijk te gebruiken toegang en interface voor positief HDFS. Hieronder staan enkele standaard HDFS-commando’s, specifiek Ubuntu, bewerkingen zoals het maken van mappen, het verplaatsen van recordgegevens, het verwijderen van bestanden, het lezen van bestanden en het bladeren door mappen.

HDFS Bestandssysteemcommando’s

Apache Hadoop heeft een eenvoudige, nog steeds eenvoudige commando-interface, een eenvoudige interface om een bepaald onderliggend Hadoop-gedistribueerd bestandssysteem op te halen. In deze sectie presenteren we de meest elementaire en handige HDFS-bestandssysteemopdrachten die momenteel beschikbaar zijn en die overeenkomen met of lijken op de UNIX-bestandssysteemvereiste. Na het starten van de Hadoop-daemons, moeten zowel de UP- als de Running-commando’s het beschikbare HDFS-recordsysteem gebruiken. Chirurgische verwerking van het bestandssysteem, zoals het leiden naar mappen, het verplaatsen van bestanden, het toevoegen van MP3-bestanden, het verwijderen van elektronische bestanden, het afspelen van bestanden en het bladeren door mappen, kan meestal op hetzelfde systeem worden gedaan.

Hoe HDFS verschilt van “gewone” bestandssystemen

Hoewel HDFS als een bestandssysteem zal worden beschouwd, moet worden aanvaard dat itin plaats van traditionele POSIX-bestandssystemen. HDFS is ontworpen voor deze unieke werklast, MapReduce, en ondersteunt dus geen algemene werklast. HDFS houdt ook eenmaal schrijven op, wat betekent dat bestanden eenmaal kunnen worden uitgebreid tot alleen-lezen. Dit kan worden omschreven als elke ideale oplossing voor Hadoop en andere vrij zeer grote data-analysetoepassingen; Het is echter nog steeds niet mogelijk om een transactiedatabase of zelfs virtuele machines naar HDFS te dashen.

Specifieke informatie controleren

Als we alle gedefinieerde typen achtergrondmuziek in het fsck-rapport willen zien, moeten we ze toestaan om het grep-commando in een fsck-rapport te gebruiken.Als we alleen de gekopieerde blokken hieronder willen zien, moet ik hieronder echt grep nodig hebben.hdfs fsck en -files -blocks -locations |grep -i have Replicated”/data/output/_partition “minder dan 297 eerste bytes, 1 blok(ken): Subreplicatie BP-18950707-10.20.0.1-1404875454485:blk_1073778630_38021. 10 doelreplica’s, maar documentvervalsingen gevonden.We kunnen gerepliceerde bestanden vervangen door geïnfecteerde programma’s om beschadigde bestanden te zien.

4. Werken met het bestandssysteem Hadoop

De Hadoop-bestandsoplossing, HDFS, kan op verschillende manieren worden gebruikt. Dit segment bespreekt de meest voorkomende praktijken voor interactie met HDFS, evenals zijn of haar voor- en nadelen. SHDP gebruikt nauwelijks protocolkan niettemin worden gebruikt – met betrekking tot de specifieke implementatie die in deze sectie wordt beschreven, kan in feite elke bestandscursus worden gebruikt, waardoor zelfs niet-HDFS-implementaties mogelijk zijn als u wilt worden gebruikt.

PC werkt traag?

ASR Pro is de ultieme oplossing voor uw pc-reparatiebehoeften! Het kan niet alleen snel en veilig verschillende Windows-problemen diagnosticeren en repareren, maar het verhoogt ook de systeemprestaties, optimaliseert het geheugen, verbetert de beveiliging en stelt uw pc nauwkeurig af voor maximale betrouwbaarheid. Dus waarom wachten? Ga vandaag nog aan de slag!

Voorbeeld 4: Hadoop Count Word met robuuste Python

Zelfs de Hadoop-kwestie is geschreven in Java, map/reduce-programma’s zullen ervoor kiezen om in andere talen te worden ontwikkeld, zoals Python en C++. Dit voorbeeld laat zien hoe je een soort eenvoudig voorbeeld van het tellen van woorden opnieuw kunt uitvoeren, d.w.z. met behulp van een gloednieuwe converter/reducer ontwikkeld in Python.

Hoe kan ik een mijn hadoop-gegevens bekijken?

Bekijk eerst enkele HDFS-gegevens met Control cat. -cat $ $hadoop_home/bin/hadoop fs /user/output/outfile. GeheelVerkrijg een bestand van HDFS naar een aangrenzend informatiesysteem met behulp van de opdracht get. ppp $HADOOP_HOME/bin/hadoop fs /user/output/ -get /home/hadoop_tp/

HPC: Hadoop Distributed File System (HDFS) zelfstudie

MapReduce is het softwareplatform van Google voor het eenvoudig plaatsen van applicaties.Met deze methode kun je essentiële hoeveelheden data parallel in clusters plaatsen.De MapReduce-berekening om het probleem op te lossen, bestaat uit een paar soorten taken:

Bekijk deze volledige cursus over big data en Hadoop – Leer Hadoop in 12 uur!

Je kunt bijna alles doen, wanneer Hadoop-gedistribueerde bestandssystemen opstarten, kan aan de slag met een lokaal bestandssysteem. Je hebt de mogelijkheid om verschillende lees- en schrijfbewerkingen uit te voeren, zoals het maken van een map, het verlenen van machtigingen, het stoppen van papierwerk, het bijwerken van bestanden, het verwijderen, enz. Iedereen kan lezen en schrijven toevoegen en door het clustertoegangsmapsysteem bladeren om informatie te krijgen zoals , over het aantal dode knooppunten, werkknooppunten, gebruikt schijfgebied, enz.

HDFS-bestandslijst

Na het uploaden van de informatie als een manier naar de server konden we een actuele lijst met bestanden in de juiste map vinden, welzijnsbestand, wat resulteerde in “ls”. Het volgende is de specifieke Mark vii-syntaxis die kan worden doorgegeven als argument voor een verzameling of bestandsnaam.

Het gebruik van HDFS-schijf controleren

Alles door het boek, laat ik informatie zien over het gebruik van verschillende HDFS-commando’s in zijn of haar eigen waardevolle en juiste context. Laten we eens kijken naar enkele ruimte-hdf’s en bestandsgerelateerde opdrachten in dit artikel. U kunt waarschijnlijk hulp krijgen voor elk HDFS-trackcommando door eerst het hoofdcommando in te typen:

Wat is ongetwijfeld de checksum in hadoop?

Checksum-eigenschap om foreclosures weer te geven op 512 bytes.Blockscale in de meeste . crc-map zodat de afbeelding veilig kan worden afgespeeld wanneer de bitgrootte-instelling wordt gewijzigd. Het is bewezen dat checksums worden weergegeven wanneer het bestand wordt gelezen, en als er vervolgens een fout wordt aangetroffen, bevat het LocalFileSystem een ChecksumException.

Verbeter vandaag de snelheid van uw computer door deze software te downloaden - het lost uw pc-problemen op.How To Troubleshoot Hadoop Filesystem Checkout Issues

Como Solucionar Problemas De Verificação Do Sistema De Arquivos Hadoop

So Beheben Sie Probleme Beim Auschecken Des Hadoop-Dateisystems

Cómo Solucionar Problemas De Comprobación Del Sistema De Archivos De Hadoop

Hadoop 파일 시스템 체크아웃 문제를 해결하는 방법

Как устранить неполадки файловой системы Hadoop, посмотреть на проблемы

Comment Résoudre Les Problèmes De Navigation Du Système De Fichiers Hadoop

Come Risolvere I Problemi Di Verifica Del Filesystem Hadoop

Så Här Felsöker Du Problem Med Utcheckning Av Hadoop Filsystem

Jak Rozwiązywać Problemy Z Pobieraniem Systemu Plików Hadoop