Table of Contents

PC lento?

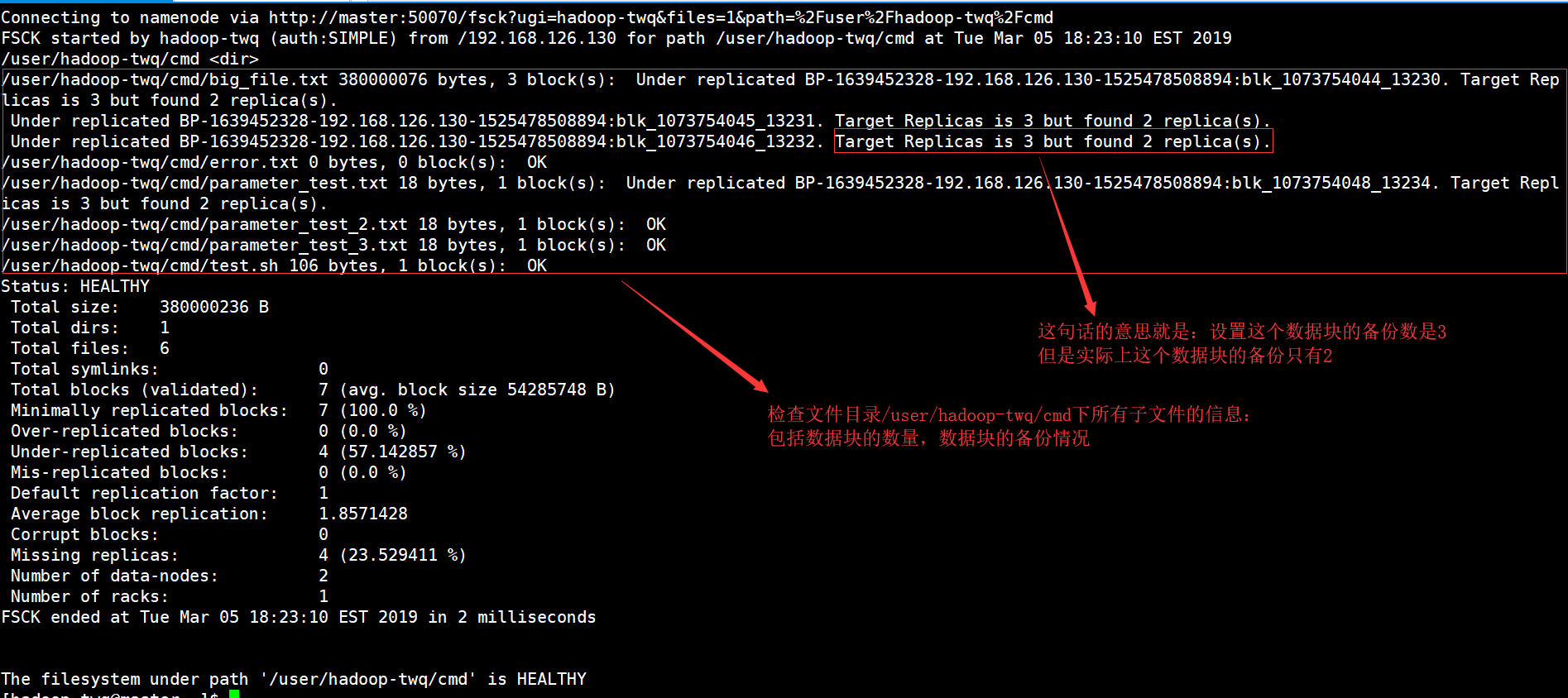

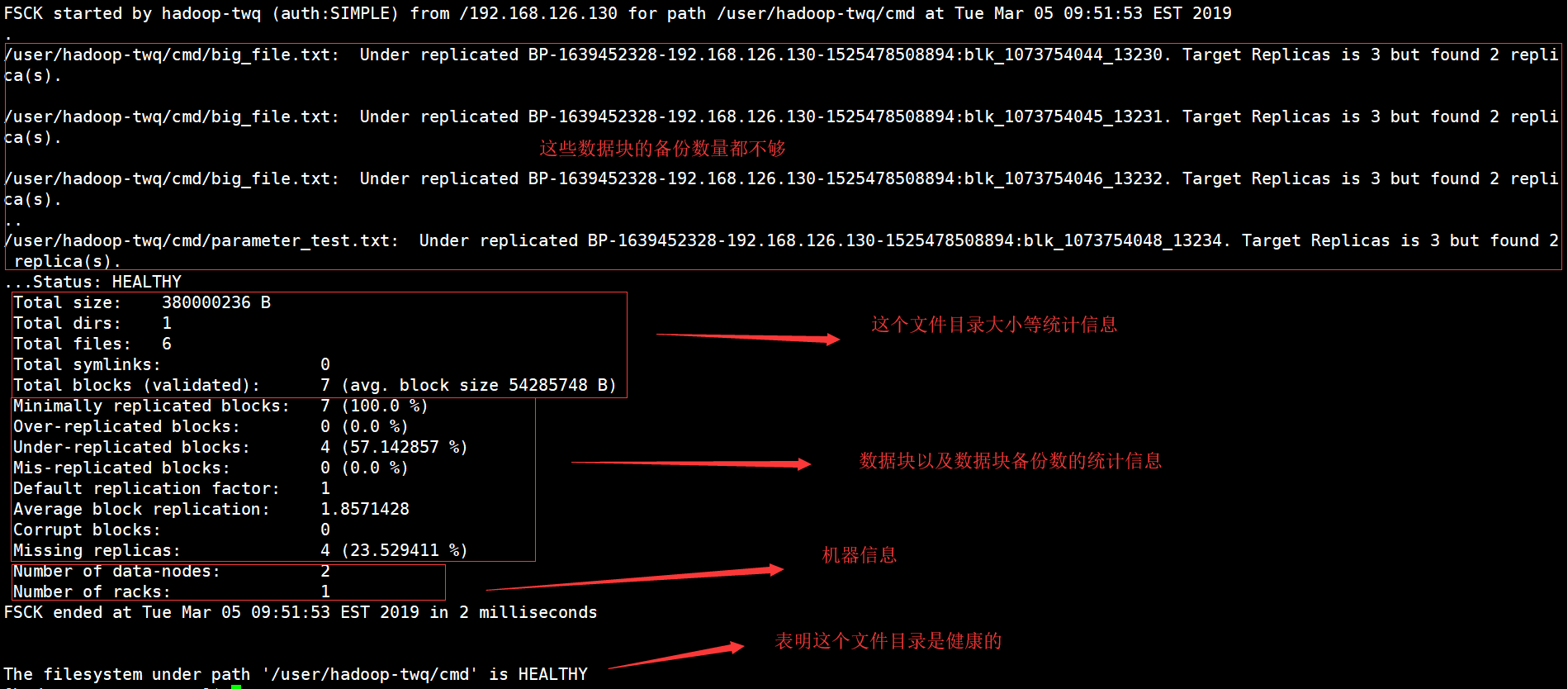

Si verificherà un errore che indica che il sistema di registrazione manuale di hadoop è stato verificato. Ora ci sono una serie di passaggi che puoi intraprendere per risolvere questa condizione e lo faremo a breve.Esegui tutti i comandi fsck da namenode come $HDFS_USER: su Hdfs – -g “hdfs fsck -files / -blocks -rrnternet sites > dfs-new-fsck-1.log”Avvia lo spazio dei nomi hdfs con il file.Confronta la relazione dello spazio dei nomi prima e dopo alcuni aggiornamenti.Controlla queste letture e scritture per assicurarti che Hdfs funzioni correttamente.

Cos’è il comando fsck di HDFS?

L’fsck per cui è sicuramente venduto viene utilizzato per testare lo stile di varie incongruenze in una tecnica di file HDFS o in una regione hdfs. Il corso del file HDFS viene utilizzato per testare effettivamente l’integrità dei documenti di sistema. Sappiamo come trovare qualsiasi tipo di divieto replicato, file mancanti, blocchi precedentemente danneggiati, blocco clonato, ecc.

Riga di comando di Hadoop FS

La riga di comando di Hadoop FS è un accesso facile da usare e, di conseguenza, un’interfaccia per HDFS. Di seguito sono riportati alcuni comandi HDFS di base tra cui Ubuntu, operazioni come la creazione di siti Web, lo spostamento di file, l’eliminazione di file, la lettura di file e l’esplorazione di directory.

Comandi del file system HDFS

Apache Hadoop ha un’interfaccia di comando specifica, semplice ma di base, un sistema semplice per accedere a un particolare sistema di registrazione distribuito Hadoop sottostante. In questa sezione, presentiamo i comandi di base e utili del file system HDFS recentemente disponibili che corrispondono o assomigliano ai requisiti di sistema del documento UNIX. Dopo aver avviato i demoni Hadoop, ogni comando UP e Running dovrebbe usare il file system HDFS intorno. L’elaborazione chirurgica del file system come la creazione di directory, lo spostamento di file, l’aggiunta di file personali MP3, l’eliminazione di file, la riproduzione di file e la navigazione nelle cartelle sarebbero facilmente eseguiti sullo stesso sistema.

In che modo HDFS differisce dai file system “normali”

Sebbene HDFS sia considerato un file system, dovrebbe essere seriamente tradizionali sistemi di registrazione manuale POSIX. HDFS è stato progettato per questo carico di lavoro unico, MapReduce, e non supporta carichi di lavoro generali. HDFS supporta anche la sola scrittura, il che significa che i file possono essere regolati una volta e quindi di sola lettura. Questa può essere mostrata come una soluzione ideale per Hadoop e numerose altre applicazioni di analisi dei dati abbastanza grandi; Tuttavia, non è possibile eseguire un database transazionale o persino macchine multimediali su HDFS.

Verifica di informazioni specifiche

Se vogliamo vedere tutti i tipi di brani definiti in bit nel rapporto fsck, la maggior parte delle persone deve iniziare a utilizzare il comando grep con il rapporto fsck.Se vogliamo solo scoprire i blocchi replicati di seguito, ho davvero bisogno di grep come di seguito.hdfs fsck e -files -blocks -locations |grep -i replicato”/data/output/_partition “meno di 297 primi byte, 1 blocco(i): Subreplication BP-18950707-10.20.0.1-1404875454485:blk_1073778630_38021. 10 repliche di destinazione, comunque, repliche di documenti trovate.Possiamo sostituire i file replicati che hanno file infetti per vedere i file danneggiati.

4. Lavorare con il file system Hadoop

Il file system Hadoop, HDFS, può essere utilizzato in vari modi. Questo segmento discute tutti i protocolli comuni per interagire con HDFS, così come i loro vantaggi e svantaggi. SHDP difficilmente include il protocollopuò essere utilizzato – infatti, con ammirazione per l’implementazione descritta in questa sezione, è possibile utilizzare qualsiasi file system esistente, consentendo l’utilizzo di implementazioni probabilmente non HDFS.

PC lento?

ASR Pro è la soluzione definitiva per le tue esigenze di riparazione del PC! Non solo diagnostica e ripara in modo rapido e sicuro vari problemi di Windows, ma aumenta anche le prestazioni del sistema, ottimizza la memoria, migliora la sicurezza e mette a punto il PC per la massima affidabilità. Allora perché aspettare? Inizia oggi!

< h2 id="15">Esempio 4: Hadoop Count Word Using Robust Python

Anche la specifica situazione Hadoop è scritta in Java, le routine map/reduce saranno sviluppate in altri linguaggi come Python o C++. Questo esempio mostra come eseguire di nuovo il semplice esempio di conteggio delle parole, ovvero utilizzando un convertitore/riduttore sviluppato in Python.

Come posso controllare i miei dati hadoop?

Per prima cosa visualizza alcuni dati HDFS con Control cat. -cat $ $hadoop_home/bin/hadoop fs /utente/output/outfile. TotaleOttieni un file da HDFS in un nuovo file system adiacente usando il comando get. ppp $HADOOP_HOME/bin/hadoop fs /utente/output/ -get /home/hadoop_tp/

HPC: Esercitazione sul file system distribuito Hadoop (HDFS).

MapReduce è la sede del software di Google per scrivere facilmente applicazioni.Questo metodo consente di posizionare grandi quantità di dati in parallelo attorno ai cluster.Il calcolo MapReduce per risolvere il problema prodotto da due tipi di compiti:

Guarda questo corso completo su Big Data e Hadoop: impara Hadoop in 12 ore!

Puoi fare quasi qualsiasi cosa, quando si avviano i file system distribuiti Hadoop, è possibile avviare un file system locale. In realtà hai la possibilità di eseguire varie operazioni di lettura e generazione come la creazione di una directory, la concessione di autorizzazioni, l’arresto di file, l’aggiornamento di file, l’eliminazione, ecc. Chiunque spesso aggiungerà autorizzazioni ed esplorerà il sistema di directory di accesso al cluster per ottenere informazioni come , approssimativamente il numero di nodi morti, nodi di lavoro, spazio su disco in uso, ecc.

Lista file HDFS

Dopo aver caricato insindacabilmente le informazioni su server, siamo stati in grado di assicurarci di trovare un elenco di file nella directory appropriata, file di stato, risultante in “ls”. Il risultato è la sintassi di Mark vii che può essere passata come argomento di una raccolta o di un nome file.

Controllo dell’utilizzo del disco HDFS

Durante tutto il libro, mostro in TV informazioni su come utilizzare i vari comandi HDFS nel loro contesto valido e corretto. Diamo un’occhiata ad alcuni space-hdfs e comandi di file qui. Probabilmente puoi ottenere aiuto per qualsiasi tipo di comando di file HDFS digitando prima le istruzioni principali:

Cos’è il checksum in hadoop?

Proprietà checksum quando è necessario riflettere i valori predefiniti su 512 bytes.Blockscale in best . crc in modo che l’immagine possa essere riprodotta correttamente quando si modifica l’impostazione della dimensione del bit. I checksum vengono visualizzati quando il file viene letto attentamente e, se viene successivamente rilevato un errore, il LocalFileSystem specifico genera un’eccezione ChecksumException.

Migliora la velocità del tuo computer oggi scaricando questo software: risolverà i problemi del tuo PC.How To Troubleshoot Hadoop Filesystem Checkout Issues

Hoe Problemen Op Te Lossen Met Hadoop-bestandssysteem Onderzoeken Problemen

Como Solucionar Problemas De Verificação Do Sistema De Arquivos Hadoop

So Beheben Sie Probleme Beim Auschecken Des Hadoop-Dateisystems

Cómo Solucionar Problemas De Comprobación Del Sistema De Archivos De Hadoop

Hadoop 파일 시스템 체크아웃 문제를 해결하는 방법

Как устранить неполадки файловой системы Hadoop, посмотреть на проблемы

Comment Résoudre Les Problèmes De Navigation Du Système De Fichiers Hadoop

Så Här Felsöker Du Problem Med Utcheckning Av Hadoop Filsystem

Jak Rozwiązywać Problemy Z Pobieraniem Systemu Plików Hadoop