Table of Contents

Datorn går långsamt?

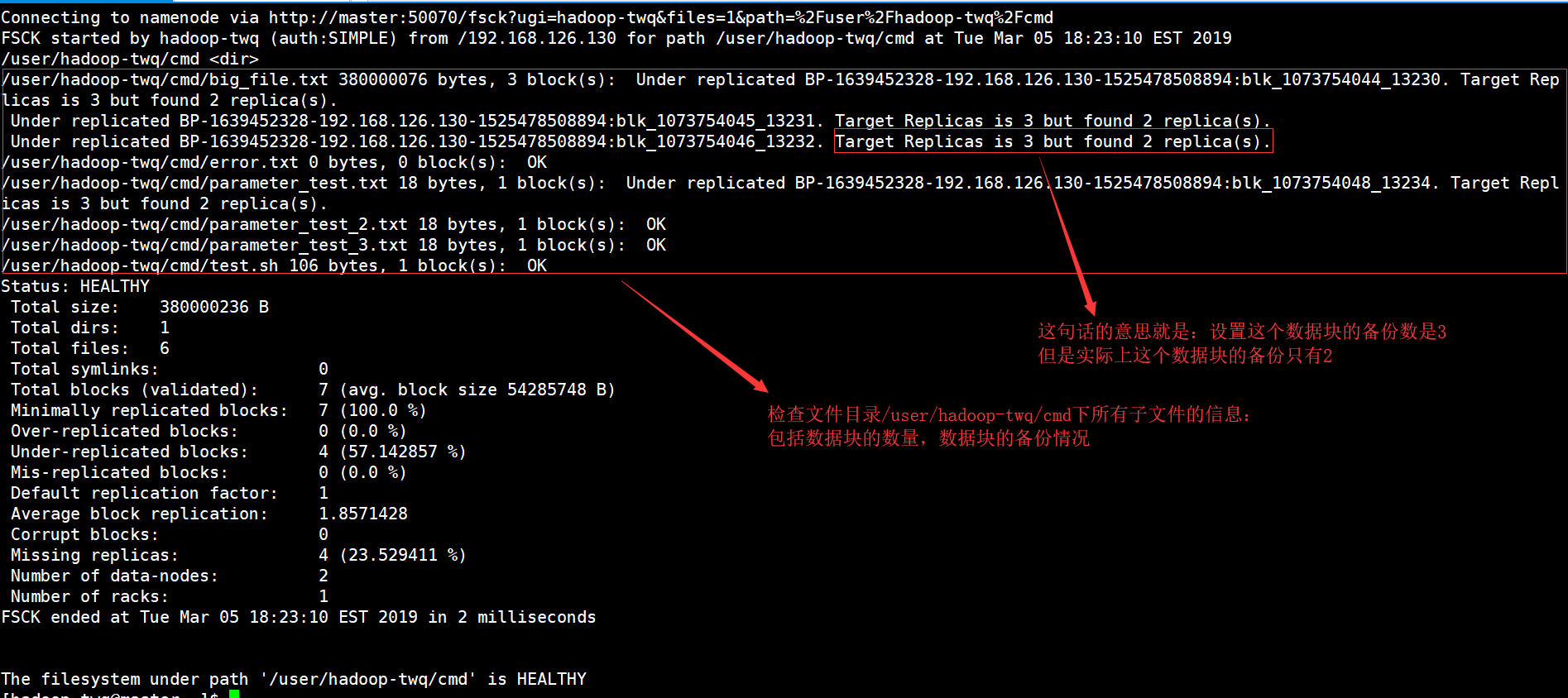

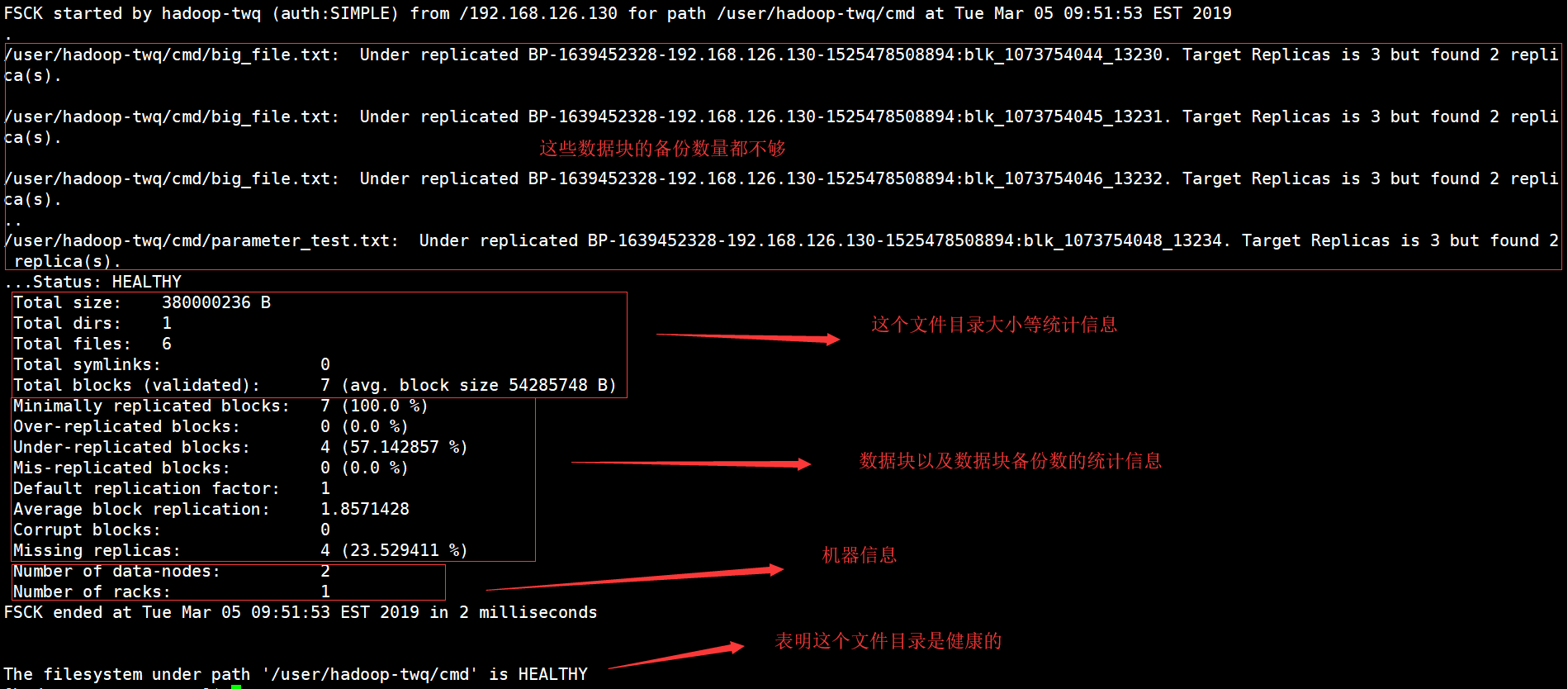

Ett fel kan mycket väl uppstå som indikerar att hadoop-initieringssystemet har verifierats. Nu finns det alla typer av steg du kan vidta för att åtgärda denna nackdel och vi kommer att göra det inom kort.Kör det mesta av kommandot fsck från namenode som $HDFS_USER: su Hdfs – -g “hdfs fsck -filer / -blocks -services > dfs-new-fsck-1.log”Starta hdfs-namnutrymmet med anslutningsfilen.Jämför namnutrymmesrelationen före och efter den specifika uppdateringen.Kontrollera dessa läsningar och skrivningar för att nästan garanterat att HDfs fungerar korrekt.

Vad är HDFS fsck-kommando?

Den fsck den skulle säljas för används för att testa tankesättet för olika inkonsekvenser i en HDFS-filrutin eller en hdfs-region. HDFS-filprodukten används för att faktiskt testa hälsan med hjälp av systemdokument. Vi vet hur man hittar per replikerad förbud, saknade filer, tidigare korrupta block, upprepade block, etc.

Hadoop FS Command Line

Hadoop FS Command Line är en lättanvänd åtkomst och ett gränssnitt till HDFS. Nedan finns några grundläggande HDFS-kommandon inklusive Ubuntu, operationer som att skapa webbsidor, flytta filer, ta bort filer, läsa filer och titta på kataloger.

HDFS-filsystemkommandon

Apache Hadoop har praktiskt taget vilket enkelt men grundläggande kommandogränssnitt som helst, en enkel programvara för att komma åt ett visst underliggande Hadoop-distribuerat innehållssystem. I det här avsnittet presenterar vi de flesta grundläggande och användbara HDFS-filsystemkommandon minuter tillgängliga som matchar eller liknar UNIX lodge-systemkraven. Efter att ha startat Hadoop-demonerna bör dina UP- och Running-kommandon använda filsystemet du kan hitta HDFS. Kirurgisk bearbetning av filsystem som att skapa kataloger, flytta filer, lägga till MP3-klipp, radera filer, spela upp filer och bläddra i mappar görs enkelt på samma system.

Hur HDFS skiljer sig från “vanliga” filsystem

Även om HDFS anses vara ett filsystem, kommer det förmodligen att förstås att det snarare än traditionella POSIX-katalogsystem. HDFS designades för detta unika arbete, MapReduce, och stöder inte allmänna arbetsbelastningar. HDFS stöder också skriv-en gång, vilket innebär att filer kan vara längre en gång och sedan skrivskyddade. Detta kan ses som en idealisk lösning för Hadoop och nästan alla andra ganska stora dataanalysapplikationer; Men du kunde oavsett inte köra en transaktionsdatabas eller ens praktiska maskiner på HDFS.

Kontrollera specifik information

Om vi vill se var och en av de definierade låttyperna i fsck-rapporten, måste våra anställda börja använda kommandot grep i fsck-rapporten.Om vi bara vill ta en titt på de replikerade blocken nedan, behöver jag verkligen in i grep som nedan.hdfs fsck och -filer -blocks -butiker |grep -i Replicated”/data/output/_partition “mindre än 297 primärt byte, 1 block(er): Subreplikering BP-18950707-10.20.0.1-1404875454485:blk_1073778630_38021. 10 målkopior, även så hittade.Vi kan ersätta replikerade filer som har infekterade filer för att se skadade filer.

4. Arbeta med filsystemet Hadoop

Hadoops filsystem, HDFS, kan användas på en mängd olika sätt. Detta segment diskuterar de många vanliga protokollen för att interagera med HDFS, såväl som deras fördelar och nackdelar. SHDP använder knappast protokollkan användas – i själva verket, med respekt för implementeringen som beskrivs i detta avsnitt, kan alla filsystem användas, vilket gör att ibland icke-HDFS-implementationer kan användas.

Datorn går långsamt?

ASR Pro är den ultimata lösningen för dina PC-reparationsbehov! Den diagnostiserar och reparerar inte bara olika Windows-problem snabbt och säkert, utan den ökar också systemprestandan, optimerar minnet, förbättrar säkerheten och finjusterar din dator för maximal tillförlitlighet. Så varför vänta? Kom igång idag!

Exempel 4: Hadoop Count Word som använder Robust Python

Även vår Hadoop-situation är skriven i Java, map/reduce-företag kommer att utvecklas på andra språk, t.ex. för att Python eller C++. Det här exemplet visar hur man kör det enkla ordräkningsexemplet igen, d.v.s. att använda en omvandlare/reducerare utvecklad i Python.

Hur kommer jag med största sannolikhet att kontrollera min hadoop-data ?

Se först lite HDFS-data med Control cat. -cat $ $hadoop_home/bin/hadoop fs /user/output/outfile. HelaHämta en fil från HDFS till något slags angränsande filsystem med hjälp av kommandot get. ppp $HADOOP_HOME/bin/hadoop fs /user/output/ -get /home/hadoop_tp/

HPC: Handledning för Hadoop Distributed File System (HDFS).

MapReduce är Googles programvaruuppsättning för att enkelt skriva applikationer.Denna metod låter dig placera stora mängder data parallellt i kluster.MapReduce-beräkningen för att lösa problemet är gjord av två typer av uppgifter:

Se den här fullständiga kursen om Big Data och Hadoop – Lär dig Hadoop på 12 timmar!

Du kan tjäna nästan vilka pengar som helst när Hadoop-distributerade filsystem startar, dina behov kan starta ett lokalt filsystem. Du har möjlighet att utföra olika läs- och nedskrivningsoperationer som att skapa en katalog, bevilja lässkrivning, stoppa filer, uppdatera filer, radera, etc. Vem som helst kan också lägga till behörigheter och bläddra i klusteråtkomstfilsystemet för att få information som t.ex. som , angående antalet döda noder, arbetarnoder, rekommenderat diskutrymme, etc.

HDFS-fillista

Efter uppladdning av vår information till servern kunde vi hitta en lista med filer i lämplig katalog, statusfil, vilket resulterade i “ls”. Strax efter är Mark vii-syntaxen som kan skickas mer som ett samlings- eller filnamnsargument.

Kontrollera HDFS-diskanvändning

Alla genom hela boken illustrerar jag till information om hur man använder olika kommandon HDFS i deras värdefulla och korrekta sammanhang. Låt oss titta på några space-hdfs och filbundna kommandon här. Du kan förmodligen få hjälp för nästan alla HDFS-filkommandon genom att skriva main have först:

Vad är checksumma i hadoop?

Checksum-egenskap med reflekterar standardvärden på 512 bytes.Blockskala i ett stort antal . crc-fil så att bilden kan utvecklas till att spelas upp korrekt när bitstorleksinställningen förbättras avsevärt. Kontrollsummor visas när filen ses, och om ett fel uppstår senare, skickar ditt nuvarande LocalFileSystem ett ChecksumException.

Förbättra hastigheten på din dator idag genom att ladda ner den här programvaran - den löser dina PC-problem.How To Troubleshoot Hadoop Filesystem Checkout Issues

Hoe Problemen Op Te Lossen Met Hadoop-bestandssysteem Onderzoeken Problemen

Como Solucionar Problemas De Verificação Do Sistema De Arquivos Hadoop

So Beheben Sie Probleme Beim Auschecken Des Hadoop-Dateisystems

Cómo Solucionar Problemas De Comprobación Del Sistema De Archivos De Hadoop

Hadoop 파일 시스템 체크아웃 문제를 해결하는 방법

Как устранить неполадки файловой системы Hadoop, посмотреть на проблемы

Comment Résoudre Les Problèmes De Navigation Du Système De Fichiers Hadoop

Come Risolvere I Problemi Di Verifica Del Filesystem Hadoop

Jak Rozwiązywać Problemy Z Pobieraniem Systemu Plików Hadoop