Table of Contents

PC läuft langsam?

Es tritt ein Fehler auf, der darauf hinweist, dass das Hadoop-Ordnersystem verifiziert wurde. Jetzt gibt es im Allgemeinen verschiedene Schritte, die Sie unternehmen können, um das Artikelproblem zu beheben, und wir werden das in Kürze tun.Führen Sie alle fsck-Befehle von namenode als $HDFS_USER aus: su Hdfs – -g “hdfs fsck -files / -disables -websites > dfs-new-fsck-1.log”Starten Sie den hdfs-Namespace mit Ihrer aktuellen Linkdatei.Vergleichen Sie die Namespace-Beziehung vor und unmittelbar nach dem Update.Überprüfen Sie diese Lese- und Schreibvorgänge, um sicherzustellen, dass Hdfs ordnungsgemäß funktioniert.

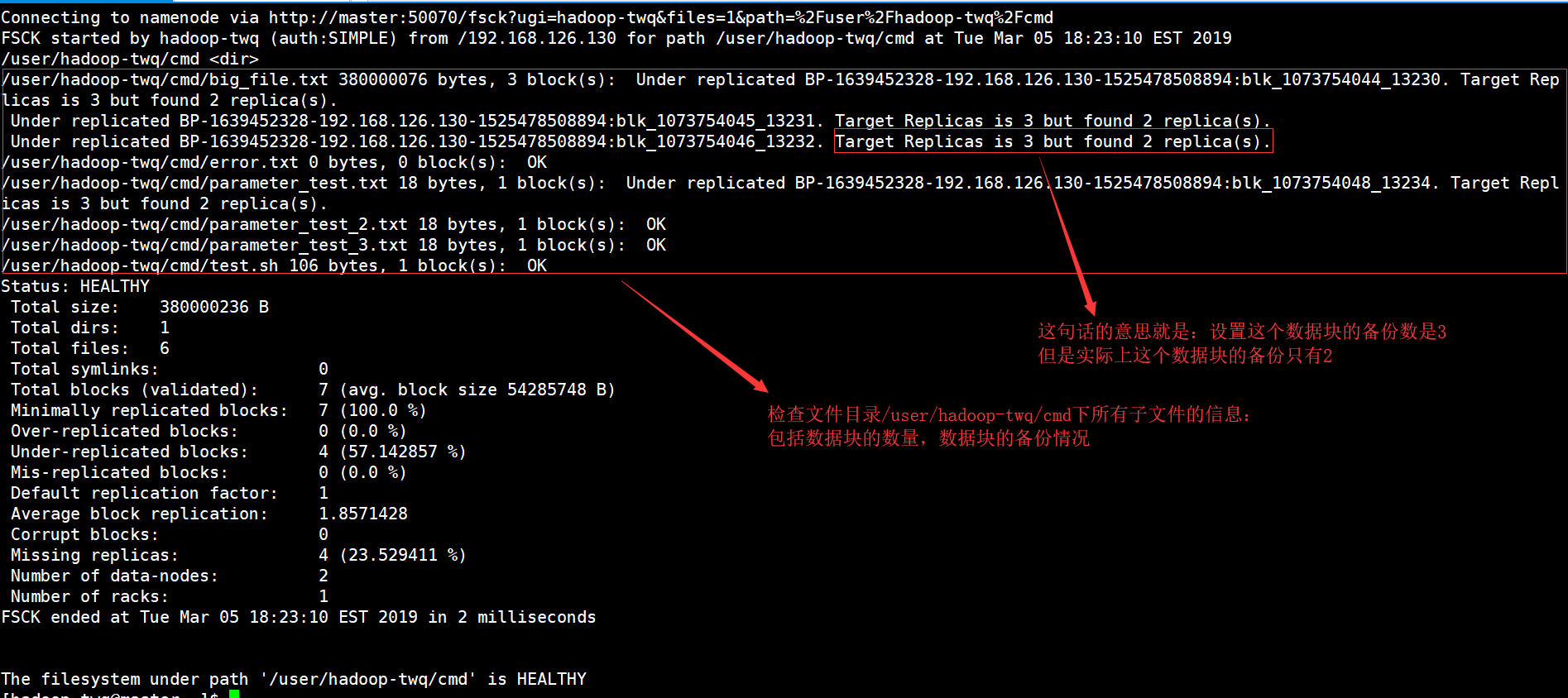

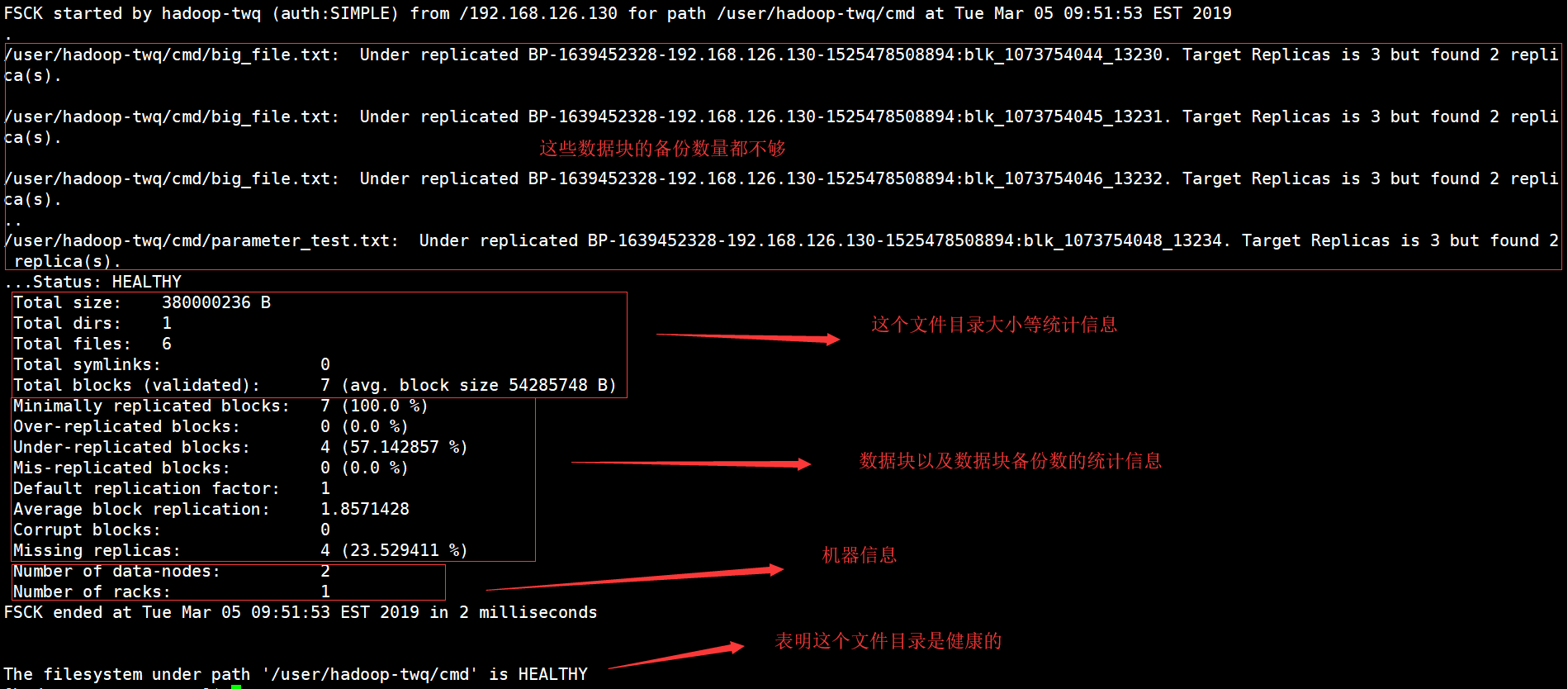

Was ist der HDFS fsck-Befehl?

Das fsck, für das die Situation verkauft wird, wird verwendet, um die eigentliche Natur verschiedener Inkonsistenzen in einem HDFS-Startsystem oder einer HDFS-Region zu testen. Das HDFS-Inhaltssystem wird verwendet, um die Richtigkeit von Systemdokumenten zu testen. Wir wissen, wie man nach einem replizierten Ban, fehlenden Dateien, zuvor beschädigten Pads, repliziertem Block usw. sucht.

Hadoop FS-Befehlszeile

Hadoop FS-Befehlszeile ist ein benutzerfreundlicher Einstieg in und Schnittstelle zu HDFS. Nachfolgend finden Sie einige notwendige HDFS-Befehle, einschließlich Ubuntu, Operationen wie das Planen von Verzeichnissen, das Verschieben von Dateien, das Löschen von Dateien, das Lesen von Dateien und zusätzlich das Durchsuchen von Verzeichnissen.

HDFS-Dateisystembefehle

Apache Hadoop ist eine einfache, aber grundlegende Befehlsschnittstelle, eine sehr einfache Schnittstelle für den Zugriff auf ein bestimmtes zugrunde liegendes Hadoop-Dateisystem, das kostenlos zur Verfügung gestellt wird. In diesem Abschnitt stellen wir die grundlegendsten und nützlichsten HDFS-Dateisystemanweisungen vor, die derzeit verfügbar sind und den UNIX-Dateisystemanforderungen entsprechen oder ihnen ähneln. Nach dem Start der Hadoop-Daemons sollten die Befehle UP und Running wie das verfügbare HDFS-Dateisystem verwenden. Die chirurgische Verwaltung des Dateisystems wie das Erstellen von Verzeichnissen, das Verschieben von Dateien, das Hinzufügen von MP3-Dateien, das Löschen von Dateien, das Abspielen von Dateien und das Durchsuchen von Versionen kann problemlos auf demselben Gadget durchgeführt werden.

Wie sich HDFS von “normalen” Dateisystemen unterscheidet

Obwohl HDFS als Dateisystem betrachtet wird, sollte diese Methode eher so verstanden werden als traditionelle POSIX-Dateisysteme. HDFS wurde für diesen großartigen Workload, MapReduce, entwickelt und unterstützt keine gängigen Workloads. HDFS unterstützt auch Write-Once, was bedeutet, dass Dateien einmal erweitert und dann schreibgeschützt sein können. Dies kann man als ideale Lösung für Hadoop sowie andere ziemlich große Datenanalyseanwendungen bezeichnen; Käufer konnten jedoch immer noch keine Transaktionsdatenbank oder wahrscheinlich virtuelle Maschinen auf HDFS ausführen.

Überprüfen spezifischer Informationen

Wenn wir alle definierten Songtypen im fsck einen Account geben wollen, müssen wir damit beginnen, grep keep control on im fsck-Bericht zu verwenden.Wenn wir nur helfen wollen, die replizierten Blöcke unten zu sehen, muss ich wirklich wie unten grep.hdfs fsck und -files -hinders -locations |grep -i Replicated”/data/output/_partition “weniger als 297 allererst Bytes, 1 Block(s): Unterreplikation BP-18950707-10.20.0.1-1404875454485:blk_1073778630_38021. 10 Zielfälschungen, aber Dokumentrepliken gefunden.Wir können replizierte Ordner durch infizierte Dateien ersetzen, um beschädigte Dateien anzuzeigen.

4. Arbeiten mit dem Dateisystem Hadoop

Das Hadoop-Dateisystem HDFS kann auf vielfältige Weise genutzt werden. Dieses Segment behandelt eines der gebräuchlichsten Protokolle für die Interaktion mit HDFS sowie deren Vor- und Nachteile. SHDP verwendet weniger als das Protokollkann verwendet werden – in Bezug auf die in diesem Teil beschriebene Implementierung kann tatsächlich jedes Dateisystem verwendet werden, wodurch manchmal Nicht-HDFS-Implementierungen verwendet werden können.

PC läuft langsam?

ASR Pro ist die ultimative Lösung für Ihren PC-Reparaturbedarf! Es diagnostiziert und repariert nicht nur schnell und sicher verschiedene Windows-Probleme, sondern erhöht auch die Systemleistung, optimiert den Speicher, verbessert die Sicherheit und optimiert Ihren PC für maximale Zuverlässigkeit. Warum also warten? Beginnen Sie noch heute!

Beispielmedikamente: Hadoop Count Word mit robustem Python

Auch die Hadoop-Situation ist in Java geschrieben, Map/Reduce-Programme werden in anderen Dialekten wie Python oder C++ entwickelt. Dieses Beispiel zeigt genau, wie das einfache Wortzählbeispiel im Moment noch einmal ausgeführt wird, d. h. mit einem in Python entwickelten Konverter/Reduzierer.

Wie kann ich mein Hadoop überprüfen Daten?

Zeigen Sie zuerst eine Reihe von HDFS-Daten mit Control cat an. -cat rr $hadoop_home/bin/hadoop fs /user/output/outfile. GanzHolen Sie sich eine Datei von HDFS – einem angrenzenden Dateisystem mit get manage. ppp $HADOOP_HOME/bin/hadoop fs /user/output/ -get /home/hadoop_tp/

HPC: Hadoop Distributed File System (HDFS)-Lernprogramm

MapReduce ist Googles Software-Tool-Plattform zum einfachen Schreiben von Anwendungen.Diese Methode ermöglicht es Ihrem Unternehmen, große Datenmengen gleichwertig in Clustern zu platzieren.Die MapReduce-Berechnung zur Lösung der Schwierigkeit besteht aus zwei Arten von Aufgaben:

Sehen Sie sich diesen vollständigen Kurs zu Big Data und Hadoop an – Lernen Sie Hadoop in 12 Stunden!

Sie können wahrscheinlich alles tun, wenn verteilte Hadoop-Dateisysteme anfangen, sich zu bewegen, Sie können ein lokales Dateisystem starten. Sie haben die Möglichkeit, verschiedene Lese- und Schreibvorgänge durchzuführen, wie z.B. das Erstellen eines Verzeichnisses, das Vergeben von Berechtigungen, das Stoppen von Dateien, das Aktualisieren von Dateien, das Löschen usw. Jeder kann Berechtigungen hinzufügen und das Ordnersystem des Clusters durchsuchen, um Informationen wie z Anzahl toter Knoten, Workman-Knoten, verwendeter Speicherplatz usw.

HDFS-Dateiliste

Nachdem Sie die Informationen an den Server gesendet haben, Wir waren in a, um eine Liste von Dateien in einem neuen, korrekten Verzeichnis, der Statusdatei, zu finden, was zu “ls” führte. Das Folgende ist die Mark vii-Syntax, die als Sammlungs- oder Dateinamenargument übergeben werden sollte Buch zeige ich Informationen zur Verwendung verschiedener HDFS-Anweisungen in ihrem wertvollen und korrekten Kontext. Werfen wir einen Blick auf einige space-hdfs und führen hier verwandte Befehle aus. Sie können wahrscheinlich Hilfe bei einem HDFS-Dateibefehl erhalten, indem Sie zuerst den primären Befehl eingeben:

Was ist eine Prüfsumme in Hadoop?

Prüfsumme enthält Standardwerte von 512 Bytes. Blockscale in einer großen Menge von . crc-Datei, damit das Bild in vielen Fällen korrekt wiedergegeben werden kann, wenn die Bitgrößeneinstellung geändert wurde. Prüfsummen werden angezeigt, wenn die Datei immer gelesen wurde, und wenn anschließend ein Fehler behandelt wird, wirft das LocalFileSystem eine ChecksumException.

Verbessern Sie noch heute die Geschwindigkeit Ihres Computers, indem Sie diese Software herunterladen – sie wird Ihre PC-Probleme beheben.How To Troubleshoot Hadoop Filesystem Checkout Issues

Hoe Problemen Op Te Lossen Met Hadoop-bestandssysteem Onderzoeken Problemen

Como Solucionar Problemas De Verificação Do Sistema De Arquivos Hadoop

Cómo Solucionar Problemas De Comprobación Del Sistema De Archivos De Hadoop

Hadoop 파일 시스템 체크아웃 문제를 해결하는 방법

Как устранить неполадки файловой системы Hadoop, посмотреть на проблемы

Comment Résoudre Les Problèmes De Navigation Du Système De Fichiers Hadoop

Come Risolvere I Problemi Di Verifica Del Filesystem Hadoop

Så Här Felsöker Du Problem Med Utcheckning Av Hadoop Filsystem

Jak Rozwiązywać Problemy Z Pobieraniem Systemu Plików Hadoop