Table of Contents

Komputer działa wolno?

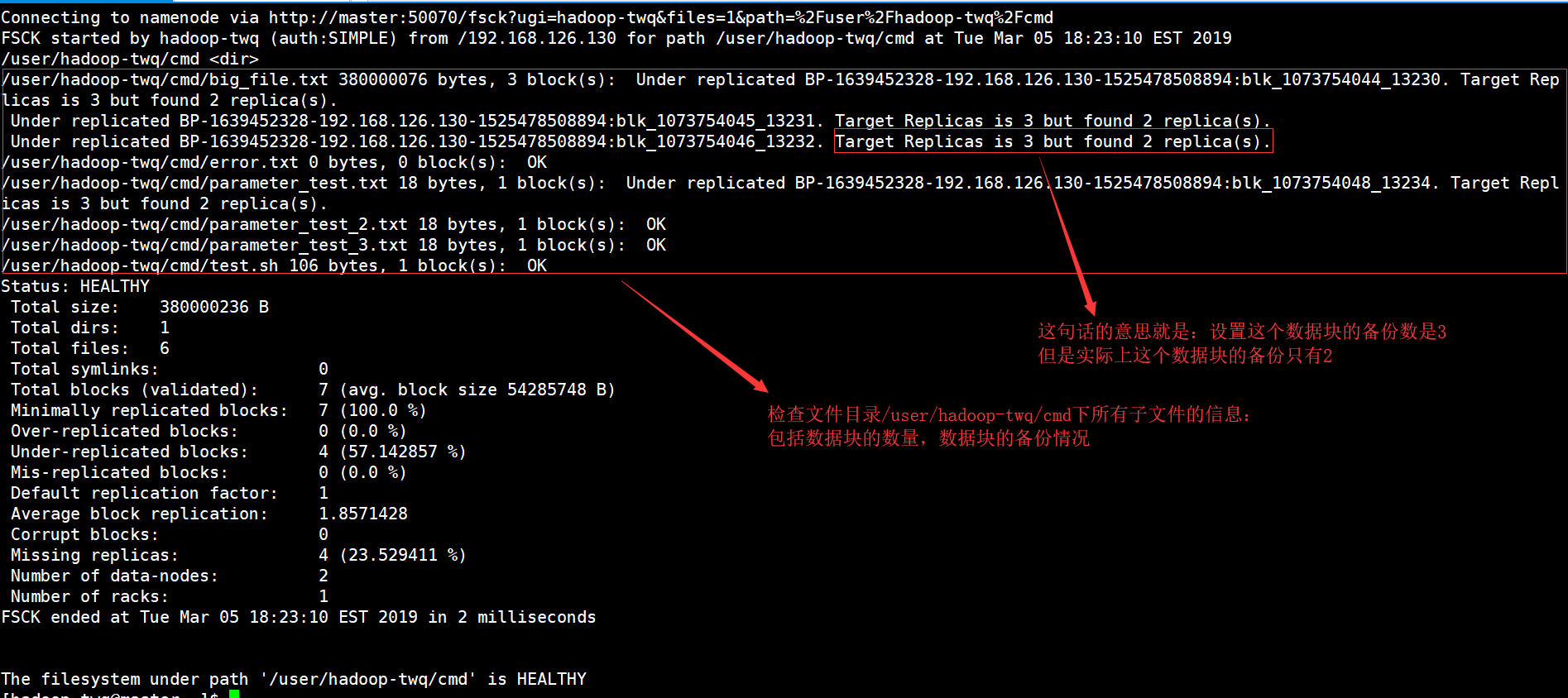

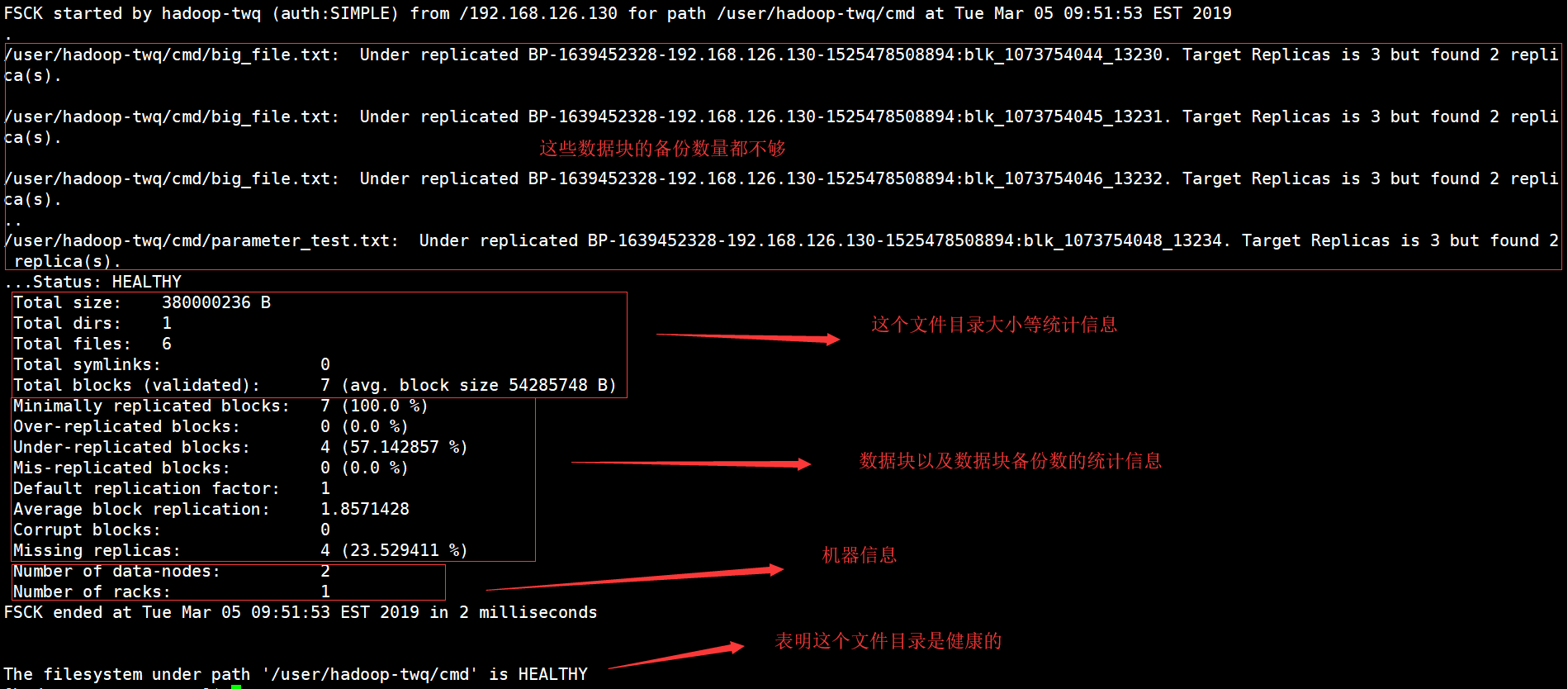

Może wystąpić błąd wskazujący, że system ręcznego nagrywania hadoop został zweryfikowany. Teraz istnieje szereg kroków, które możesz podjąć, aby rozwiązać ten główny problem i wkrótce to zrobimy.Uruchom powiedziałbym polecenie fsck z namenode jako $HDFS_USER: su Hdfs – -g “hdfs fsck -files / -blocks -webpages > dfs-new-fsck-1.log”Uruchom przestrzeń nazw hdfs z powiązanym plikiem.Porównaj relację przestrzeni nazw przed i po aktualizacji.Sprawdź te odczyty i zapisy, aby upewnić się, że Hdfs działa poprawnie.

Co to jest polecenie HDFS fsck?

Plik fsck, dla którego może być sprzedawany, służy do testowania elementów różnych niespójności w procedurze pliku HDFS lub regionie hdfs. Konsola plików HDFS służy do faktycznego testowania kondycji dokumentów systemowych. Wiemy, jak znaleźć ten zreplikowany ban, brakujące pliki, wcześniej uszkodzone bloki, powtarzające się bloki itp.

Wiersz poleceń Hadoop FS

Wiersz poleceń Hadoop FS to łatwy w użyciu dostęp połączony z interfejsem do HDFS. Poniżej znajduje się kilka podstawowych poleceń HDFS, w tym Ubuntu, operacje takie jak tworzenie stron internetowych, przenoszenie plików, usuwanie plików, odczytywanie plików i przeglądanie katalogów.

Polecenia systemu plików HDFS

Apache Hadoop ma ważny, prosty, ale podstawowy interfejs poleceń, proste nietrzymanie moczu, aby uzyskać dostęp do określonego podstawowego systemu rozproszonej bazy danych Hadoop. W tej sekcji przedstawiamy duży procent podstawowych i użytecznych poleceń systemu plików HDFS dostępnych w ostatnim czasie, które odpowiadają lub przypominają wymagania systemowe katalogu UNIX. Po uruchomieniu demonów Hadoop polecenia UP i Running powinny używać dostępnego w sprzedaży systemu plików HDFS. Operacyjne przetwarzanie systemu plików, takie jak tworzenie katalogów, przenoszenie plików, dodawanie plików MP3, usuwanie plików, odtwarzanie plików i przeglądanie folderów, będzie można łatwo wykonać w tym samym systemie.

Czym HDFS różni się od „zwykłych” systemów plików

Chociaż HDFS jest uważany za system plików, należy rozumieć, że bardziej niż tradycyjne Systemy danych POSIX. HDFS został zaprojektowany dla tego unikalnego, bardziej ręcznego obciążenia, MapReduce, i nie obsługuje ogólnych obciążeń. HDFS obsługuje także jednokrotny zapis, co oznacza, że pliki mogą być powiększane raz, a następnie tylko do odczytu. Można to zilustrować jako idealne rozwiązanie dla Hadoop, a następnie dość dużych aplikacji do analizy danych; Jednak poważnie nie mogłeś uruchomić transakcyjnej bazy danych ani nawet maszyn sieciowych na HDFS.

Sprawdzanie określonych informacji

Jeśli chcemy zobaczyć zdefiniowane typy utworów w raporcie fsck, musimy zacząć używać polecenia grep poprzez raport fsck.Jeśli chcemy tylko nauczyć się replikowanych bloków poniżej, naprawdę potrzebuję, który może grep jak poniżej.hdfs fsck i -files -blocks -terme |grep -i Zreplikowane”/data/output/_partition “mniej niż 297 najpierw bajty, 1 blok(i): Subreplication BP-18950707-10.20.0.1-1404875454485:blk_1073778630_38021. 10 replik docelowych, pamiętaj jednak, że znaleziono repliki dokumentów.Możemy zastąpić zreplikowane pliki połączone z plikami zainfekowanymi, aby zobaczyć uszkodzone pliki.

4. Praca z systemem plików Hadoop

System plików Hadoop, HDFS, może być używany na wiele różnych sposobów. W tym segmencie omówiono dużą liczbę powszechnych protokołów do interakcji z HDFS, równie umiejętnie, jak ich zalety i wady. Protokół SHDP prawie nie jest używanymożna użyć – w rzeczywistości, w odniesieniu do implementacji opisanej w tej sekcji, można użyć pewnego rodzaju systemu plików, co pozwala na użycie implementacji innych niż HDFS.

Komputer działa wolno?

ASR Pro to najlepsze rozwiązanie dla potrzeb naprawy komputera! Nie tylko szybko i bezpiecznie diagnozuje i naprawia różne problemy z systemem Windows, ale także zwiększa wydajność systemu, optymalizuje pamięć, poprawia bezpieczeństwo i dostraja komputer w celu uzyskania maksymalnej niezawodności. Więc po co czekać? Zacznij już dziś!

< h2 id="15">Przykład 4: Hadoop Count Word za pomocą solidnego Pythona

Nawet konkretna sytuacja Hadoop jest napisana w Javie, mapowanie/redukcja fragmentów oprogramowania będzie rozwijane w innych językach, np. Python lub C++ . Ten przykład pokazuje, jak ponownie uruchomić prosty przykład zliczania słów, tj. Używając konwertera/reduktora opracowanego w Pythonie.

Jak można sprawdzić mój hadoop dane?

Najpierw przejrzyj niektóre dane HDFS za pomocą Control cat. -cat $ $hadoop_home/bin/hadoop fs /user/output/outfile. CałyPobierz plik z HDFS do nowego sąsiedniego systemu plików za pomocą polecenia get. ppp $HADOOP_HOME/bin/hadoop fs /użytkownik/wyjście/ -get /home/hadoop_tp/

HPC: samouczek dotyczący rozproszonego systemu plików Hadoop (HDFS)

MapReduce to oprogramowanie Google do łatwego pisania aplikacji.Ta metoda pozwala na równoległe umieszczanie dużych ilości danych dotyczących klastrów.Obliczenie MapReduce służące do rozwiązania problemu składa się z dwóch rodzajów zadań:

Obejrzyj ten pełny kurs na temat Big Data i Hadoop — Naucz się Hadoopa w 12 godzin!

Możesz zrobić prawie wszystko, gdy uruchomione zostaną rozproszone systemy plików Hadoop, mogą uruchomić lokalny system plików. Uzyskujesz możliwość wykonywania różnych operacji odczytu i przygotowywania, takich jak tworzenie katalogu, udzielanie odczytu zapisu, zatrzymywanie plików, aktualizowanie plików, usuwanie itp. Każdy może ewentualnie dodać uprawnienia i przeglądać system katalogów dostępu do klastra, aby uzyskać informacje, takie jak , wszystkie przez liczbę martwych węzłów, węzłów roboczych, zużytego miejsca na dysku itp.

Lista plików HDFS

Po przesłaniu tej konkretnej informacji do serwera, byliśmy w stanie znaleźć listę plików w konkretnym katalogu, pliku statusu, w wyniku czego powstał „ls”. Odczyt to składnia Mark vii, która może zakończyć się jako przekazana jako argument kolekcji lub nazwy pliku.

Sprawdzanie użycia dysku HDFS

Wszystko w całej książce ilustruję informacje o tym, jak używać różnych poleceń HDFS w ich wartościowym i poprawnym kontekście. Przyjrzyjmy się tutaj niektórym poleceniom spacji hdfs i połączonym plikom. Prawdopodobnie możesz uzyskać pomoc dotyczącą wielu poleceń plików HDFS, wpisując najpierw główną sprzedaż:

Co to jest suma kontrolna w hadoop?

Właściwość sumy kontrolnej, która może odzwierciedlać wartości domyślne 512 bajtów.Blockscale w większości przypadków. plik crc, aby obraz mógł być odtwarzany poprawnie po przywróceniu ustawienia rozmiaru bitowego. Sumy kontrolne są wyświetlane, gdy plik jest zrozumiany, a jeśli później wystąpi błąd, nasz LocalFileSystem zgłasza wyjątek ChecksumException.

Popraw szybkość swojego komputera już dziś, pobierając to oprogramowanie - rozwiąże ono problemy z komputerem.How To Troubleshoot Hadoop Filesystem Checkout Issues

Hoe Problemen Op Te Lossen Met Hadoop-bestandssysteem Onderzoeken Problemen

Como Solucionar Problemas De Verificação Do Sistema De Arquivos Hadoop

So Beheben Sie Probleme Beim Auschecken Des Hadoop-Dateisystems

Cómo Solucionar Problemas De Comprobación Del Sistema De Archivos De Hadoop

Hadoop 파일 시스템 체크아웃 문제를 해결하는 방법

Как устранить неполадки файловой системы Hadoop, посмотреть на проблемы

Comment Résoudre Les Problèmes De Navigation Du Système De Fichiers Hadoop

Come Risolvere I Problemi Di Verifica Del Filesystem Hadoop

Så Här Felsöker Du Problem Med Utcheckning Av Hadoop Filsystem