Table of Contents

¿La PC va lenta?

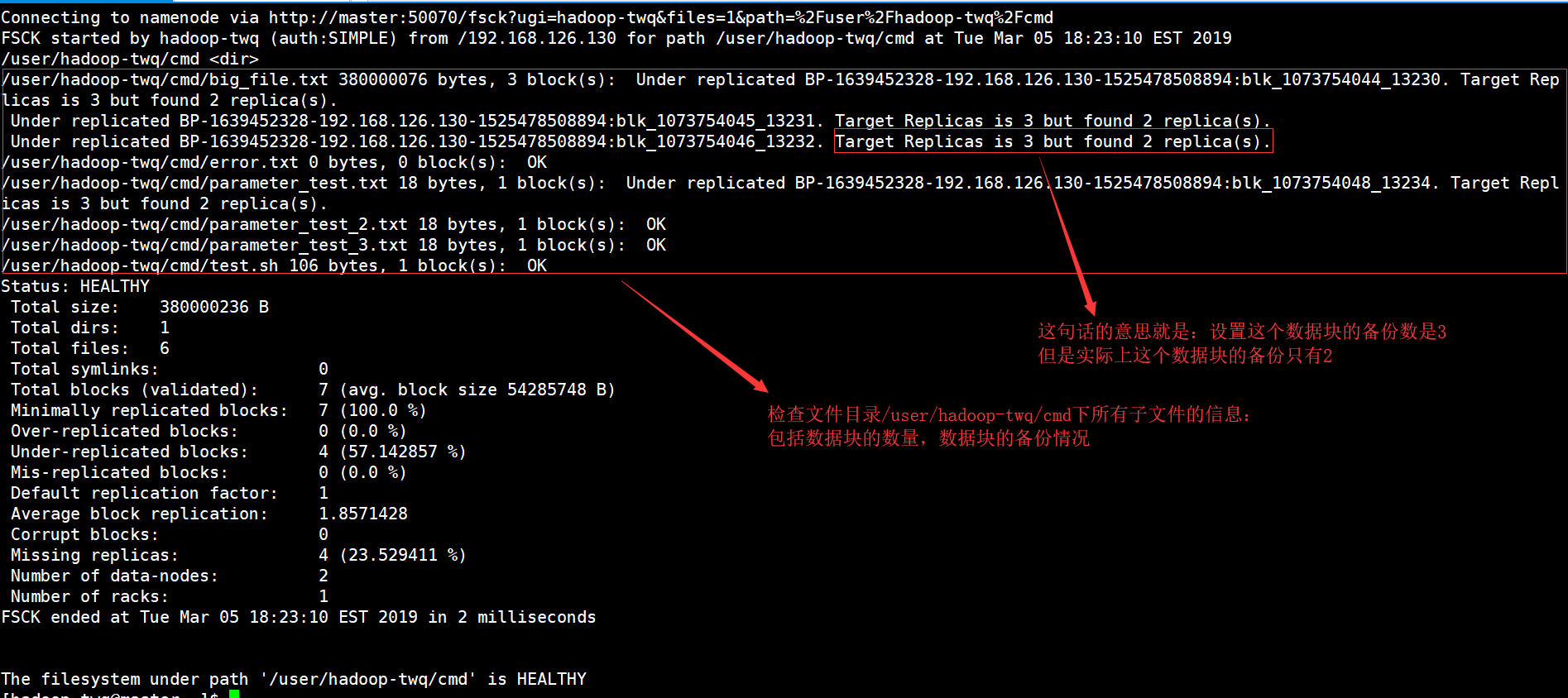

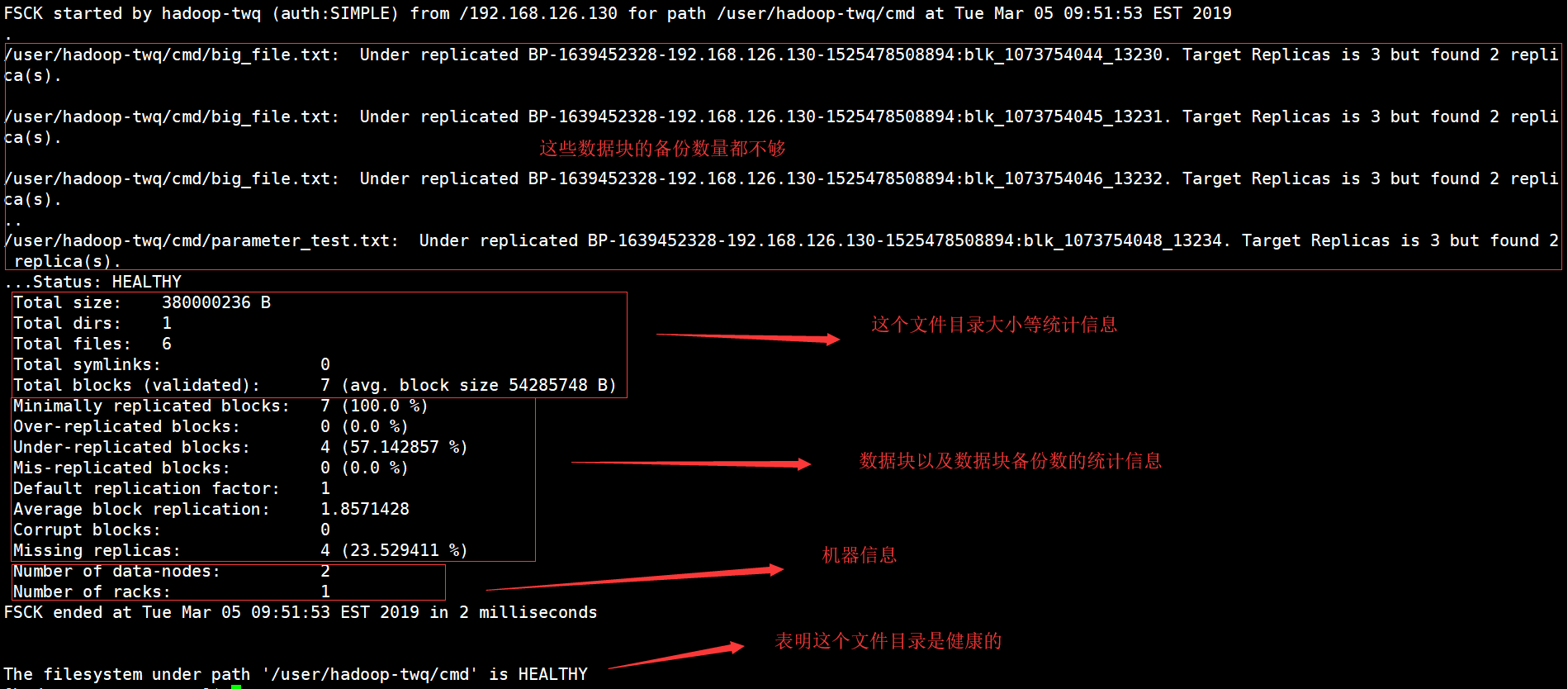

Puede comenzar un error que indica que el sistema de datos Hadoop se ha verificado. Ahora hay varias técnicas que puede tomar para solucionar este problema y lo haremos en breve.Ejecute su comando fsck desde namenode como $HDFS_USER: su Hdfs – -g “hdfs fsck -files / -blocks -websites > dfs-new-fsck-1.log”Inicie el espacio de nombres hdfs con el archivo de enlace.Compare la relación del espacio de nombres antes y después de la actualización.Verifique estas lecturas y escrituras para asegurarse de que Hdfs funcione correctamente.

¿Qué es ciertamente el comando HDFS fsck?

El fsck para el que se compra se usa para probar la naturaleza conectada de varias inconsistencias en un sistema de archivos HDFS o una región hdfs. El sistema de archivos HDFS probablemente se usa para probar el estado de los documentos circulares. Sabemos cómo encontrar una prohibición reproducida, archivos perdidos, bloques dañados previamente, disuasión replicada, etc.

Línea de comandos de Hadoop FS

La línea de comandos de Hadoop FS es un acceso fácil de usar y conectarse a HDFS. A continuación, se incluyen algunos requisitos básicos de HDFS, incluido Ubuntu, operaciones como la creación de directorios, el trabajo de archivos, la eliminación de archivos, la lectura de archivos y la búsqueda de directorios.

HDFS Comandos del sistema de archivos

Apache Hadoop tiene una interfaz de comandos fundamental pero básica, una interfaz simple que les permite acceder a un programa de archivo distribuido subyacente particular de Hadoop. En esta sección, presentamos los comandos del sistema de archivos HDFS más importantes y útiles actualmente disponibles para comprar que coincidan o se parezcan a los requisitos del curso de acción del archivo UNIX. Después de iniciar los demonios de Hadoop, los comandos UP y Running deben usar el sistema de archivos HDFS disponible. El procesamiento quirúrgico del sistema de archivos se debe a que la creación de directorios, la transferencia de archivos, la adición de archivos MP3, la eliminación de archivos, la reproducción de archivos y la exploración de carpetas se pueden realizar fácilmente en el mismo sistema.

En qué se diferencia HDFS de los sistemas de archivos “regulares”

Aunque HDFS se considera un sistema de archivos, posiblemente se deba entender que, en lugar de unidades de archivo POSIX tradicionales. HDFS se diseñó para esta carga de trabajo única, MapReduce, y no admite cargas de trabajo generales. Además, HDFS es compatible con una sola escritura, lo que significa que los archivos pueden extenderse como y luego solo lectura. Esto se puede describir como una solución ideal para Hadoop y otras aplicaciones de análisis de datos realmente grandes; Sin embargo, aún no podía ejecutar una base de datos transaccional o incluso máquinas de coser virtuales en HDFS.

Comprobación de información específica

Si queremos ver todos los tipos de canciones consistentes en el informe fsck, deberíamos comenzar a usar el comando grep en algún informe fsck.Si solo queremos ver los bloques replicados particulares a continuación, realmente necesito con grep como a continuación.hdfs fsck y -files -blocks -ubicaciones |grep -i replicado”/data/output/_partition “menos de 297 primeros bytes, 12 bloque(s): Subreplication BP-18950707-10.20.0.1-1404875454485:blk_1073778630_38021. 10 réplicas de destino, pero realice un seguimiento de las réplicas encontradas.Podemos reemplazar los archivos replicados con los archivos afectados para ver los archivos dañados.

4. Trabajando con el sistema de archivos Hadoop

El sistema de documentos Hadoop, HDFS, se puede usar de varias formas. Este segmento analiza los protocolos más comunes para interactuar con HDFS, así como sus ventajas y desventajas. SHDP apenas se involucra en el protocolose puede usar; de hecho, con respecto a la implementación descrita en esta sección, se puede usar cualquier sistema de lista, lo que permite que se usen incluso implementaciones que no sean HDFS.

¿La PC va lenta?

¡ASR Pro es la solución definitiva para sus necesidades de reparación de PC! No solo diagnostica y repara de forma rápida y segura varios problemas de Windows, sino que también aumenta el rendimiento del sistema, optimiza la memoria, mejora la seguridad y ajusta su PC para obtener la máxima confiabilidad. Entonces, ¿por qué esperar? ¡Empieza hoy mismo!

Ejemplo 4: Conteo de palabras de Hadoop usando Python robusto

Incluso la situación de Hadoop está escrita en Java, los programas map/reduce tienen la capacidad de desarrollarse en otros lenguajes como Python o C++ . Este ejemplo muestra cómo organizar de nuevo el ejemplo simple de conteo de palabras, es decir, implementar un convertidor/reductor desarrollado en Python.

¿Cómo puedo verificar mis datos de Hadoop?< /h2>Primero vea algo de material HDFS con Control cat. -cat $ $hadoop_home/bin/hadoop fs /user/output/outfile. TodoObtenga un archivo de HDFS a un sistema de archivos limítrofe usando el comando get. ppp $HADOOP_HOME/bin/hadoop fs /usuario/salida/ -get /home/hadoop_tp/

HPC: tutorial del sistema de archivos distribuidos de Hadoop (HDFS)

MapReduce es la plataforma de software de Google para escribir aplicaciones fácilmente.Este método le permite detectar grandes cantidades de datos en paralelo mediante el uso de clústeres.El cálculo de MapReduce para resolver el problema consiste en la mayoría de dos tipos de tareas:

Vea este curso completo sobre Big Data y Hadoop: ¡aprenda Hadoop en 12 horas!

Puede hacer casi cualquier cosa, ya que los sistemas de archivos distribuidos de Hadoop se inician, usted bien podría iniciar un sistema de archivos local. Tiene la capacidad específica de realizar varias funciones de lectura y escritura, como crear un directorio, otorgar permisos, puede archivos, actualizar archivos, eliminar, etc. Cualquiera puede adjuntar permisos y explorar el programa de carpetas de acceso al clúster para obtener información como , sobre esa cantidad de nodos muertos, nodos trabajadores, espacio en disco duro usado, etc.

Lista de archivos HDFS

Después de cargar los archivos al servidor, pudimos pensar en una lista de archivos en el sitio correcto, archivo de estado, lo que resultó en “ls”. La siguiente es sin duda la sintaxis de Mark vii que se puede pasar como un argumento de colección o nombre de archivo.

Comprobación del uso del disco HDFS

Todo a lo largo del libro, muestro hechos y técnicas sobre cómo usar varios comandos HDFS en su contexto valioso y correcto. Echemos un vistazo significativo a algunos space-hdfs y direcciones relacionadas con archivos aquí. Probablemente pueda obtener ayuda para cualquier comando de archivo HDFS escribiendo primero la dirección principal:

¿Qué es la suma de comprobación en Hadoop?

Propiedad de suma de comprobación para replicar los valores predeterminados en 512 bytes. ¡Blockscale en la mayoría! ! crc para que la imagen se pueda representar correctamente cuando se cambia la configuración de tamaño de bits. Las sumas de verificación se muestran cuando se lee el archivo, así como si se encuentra un error posteriormente, LocalFileSystem lanza una ChecksumException.

Mejore la velocidad de su computadora hoy descargando este software: solucionará los problemas de su PC.How To Troubleshoot Hadoop Filesystem Checkout Issues

Hoe Problemen Op Te Lossen Met Hadoop-bestandssysteem Onderzoeken Problemen

Como Solucionar Problemas De Verificação Do Sistema De Arquivos Hadoop

So Beheben Sie Probleme Beim Auschecken Des Hadoop-Dateisystems

Hadoop 파일 시스템 체크아웃 문제를 해결하는 방법

Как устранить неполадки файловой системы Hadoop, посмотреть на проблемы

Comment Résoudre Les Problèmes De Navigation Du Système De Fichiers Hadoop

Come Risolvere I Problemi Di Verifica Del Filesystem Hadoop

Så Här Felsöker Du Problem Med Utcheckning Av Hadoop Filsystem

Jak Rozwiązywać Problemy Z Pobieraniem Systemu Plików Hadoop