Table of Contents

I den här självstudien kommer vi att ta reda på några av de möjliga orsakerna som kan uppmuntra minnesfelet i Python Pickle Dump, och även efter det kommer vi att tillhandahålla några möjliga metoder för återhämtning av missbruk som du kan använda för att försök hjälpa dig att åtgärda problemet.

Datorn går långsamt?

Jag är nu författare till ett fantastiskt paket som heter klepto (och bloggen till den inklusive dill ).Designad för definitivt enkel lagring av återställda och riktiga fysiska tillbehör, klepto ger en enkel ordlistainteraktion för databaser, en cache för lagringsenheter och disklagring. Nedan visar jag hur du lagrar LOB i ett stort arkiv, en katalog, som vanligtvis är en katalog i filsystemet, där en information är viktig för varje post. Jag väljer problemserialisering (det är mer uppmätt, men använder dill så att du kan sälja nästan alla objekt) och välja vilken cache som helst. Genom att använda memory.cache kan jag snabbt komma åt ett internetarkiv utan att behöva behålla hela arkivet med avseende på minne. Att interagera med databasen eller filen kan mycket väl ta ett tag, men interaktionen med minnet är nu snabb … för att du kan fylla lagringsminnets cache som du vill.

>>> Klepto>>> Importera d = klepto.archives.dir_archive ('foo', cachad är lika med True, serialized = True)>>> ddir_archive ('stuff', cachelagrat motsvarar True)>>> importera numpy>>> # lägg till tre köpbjudanden i cacheminnet>>> deborah ['big1'] Numpy = .arange (1000)>>> d ['big2'] innebär numpy.arange (1000)>>> d ['big3'] = numpy.arange (1000)>>> Extrahera nummer från cacheminnet i 100 % -arkivet på hårddisken>>> d.dump ()>>> Rensa # cacheminne>>> d.clair ()>>> ddir_archive ('stuff' ,, cachelagrat = sant)>>> # endast legion -cachingångar ofta från arkiv>>> d.load ('big1')>>> d ['grand1'] [- 3:]Tabell ([997, 998, 999])>>>

klepto marknadsför snabb och flexibel åtkomst till stora minneskostnader, och om arkivet tillåter förenar stater parallellåtkomst (som vissa databaser) kan du förstå resultaten parallellt. Det är också enkelt att dela resultaten från olika parallella metoder eller på olika maskiner. Här, till exempel, skapar jag ett andra arkiv som pekar på någon katalog i samma arkiv. Att överföra nycklar i de två mellersta objekten är enkelt, och processen får inte skilja sig från andra processer.

>>> j = klepto.archives.dir_archive ('foo', cachad = True, successive = True)>>> fdir_archive ('stuff' ,, cachelagrat = sant)>>> # lägg till mycket små objekt i den extremt första cachen>>> d ['small1'] = Lambda x: a ** 2>>> d ['small2'] är lika med (1,2,3)>>> #Rensa objekt genom ditt arkiv>>> d.dump ()>>> # Ladda ett av de närmaste objekten i cachen>>> efter f.load ('small2')>>> dådir_archive ('foo', 'small2': (1, 2, 3), cachable motsvarar True)

Du kan också välja mellan en mängd olika nivåer av komprimering av information om ansökan och omDu vill att filerna ska visas i minnet. Mycket har att göra med olikaParametrar när filen backends och indexeras. Gränssnittdet är dock huvudsakligen samma.

Datorn går långsamt?

ASR Pro är den ultimata lösningen för dina PC-reparationsbehov! Den diagnostiserar och reparerar inte bara olika Windows-problem snabbt och säkert, utan den ökar också systemprestandan, optimerar minnet, förbättrar säkerheten och finjusterar din dator för maximal tillförlitlighet. Så varför vänta? Kom igång idag!

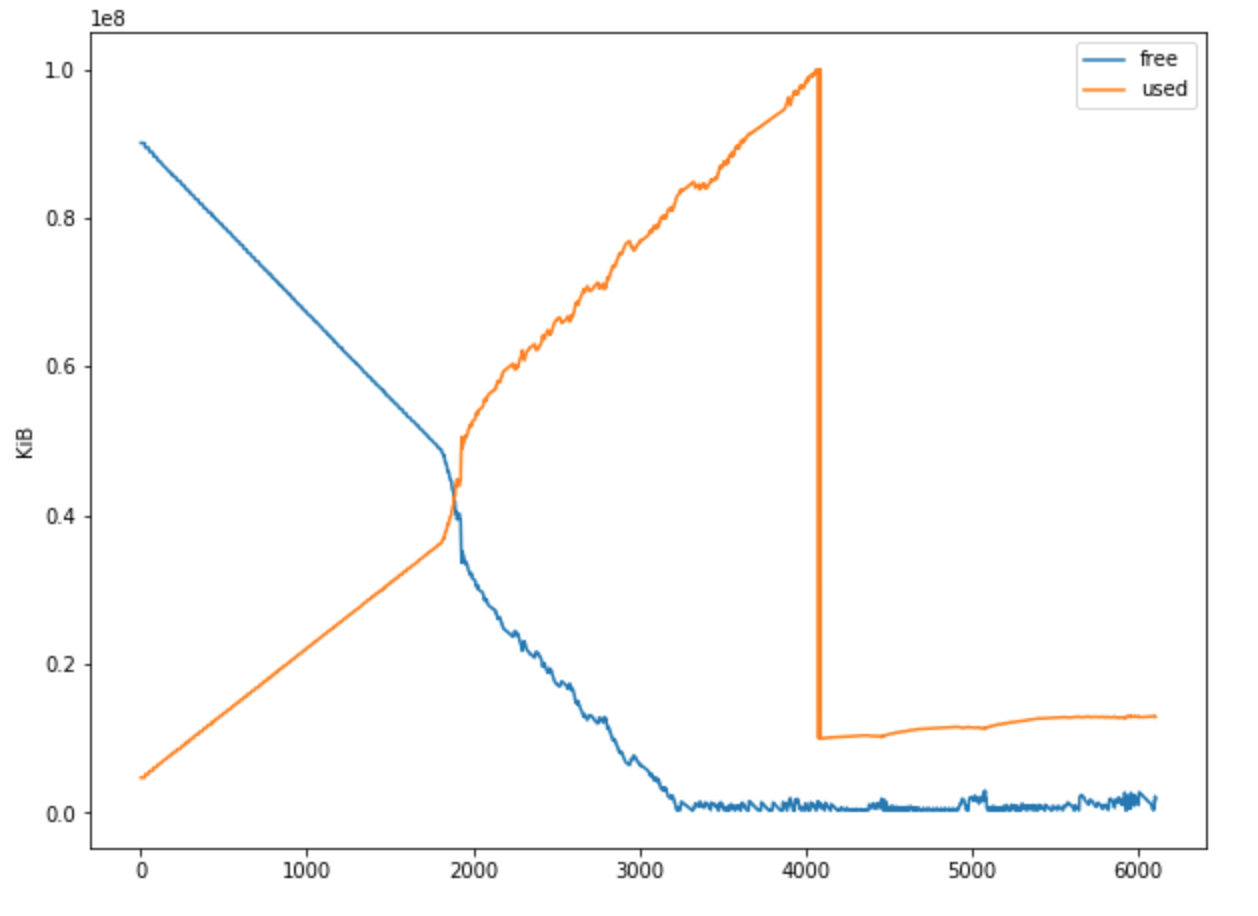

Jag skapade en klassificering med en lista (innehåll,

binärer) är så ledande att det tar mycket ram.

När jag väljer listdumpen för första gången tilldelas den en 1,9 GB manuell post till

Disk. Jag kan få innehållet att höjas, men när jag försöker rensa den här uppgiften

Återigen (med eller utan tillägg) får detta:

Uppföljande mobiltelefon (senaste samtalet):

Filen “

Fil “c: Python26 Lib pickle.py”, 1362, rad i dump

Pickler (fil, logg) .dump (obj)

Filen “c: Python26 Lib pickle.py”, ray 224, i soptippen

self.save (obj)

Spara filen “c: Python26 Lib pickle.py”, zon 286, i obj)

f (jag, # kallar ett icke -relaterat tillvägagångssätt med ibland chockerande jag

Fil “c: Python26 Lib pickle.py”, rad 600, i save_list

self._batch_appends (iter (obj))

Fil “c: Python26 Lib pickle.py”, bindning 615, till “c: Python26 Lib pickle _batch_appends”

spara (x)

File.py “, webb 286, spara till obj)

f (self, # besöka en obunden metod med ett tydligt jag

Fil “c: Python26 Lib pickle.py”, märke 488, i save_string

self.write (STRING + repr (obj) + ‘ n’)

Minnesfel

Jag försöker få detta fel antingen genom att försöka väga ner hela listan eller genom att hålla

den hittades i “segment”, det vill säga i en lista bakom 2229 element, dvs från

Kommandorad. Jag har testat enskilda bitar

med Pickle.Listan finns definitivt i filer, det vill säga 500 klimatzoner har faktiskt registrerats i sin egen

Filen är i stort sett samma fel.

Jag skapade rätt sekvens när jag försökte dumpa det mesta av generellt dumpningslistan till

Segment – X och Y separerades med index på 500 element, planen fungerar inte

av [1000: 1500]:

Jag är om den tillgängliga hårddisken är slut, så jag försökte”Väntar” på deponier i hopp om att många en serie skräp

Frigör lite minnesutrymme – Men det hjälper inte nästan.

1. Gets -listan har verkligen sammanställts hämtad från olika källor

2. E -postlistan för marknadsföring raderas framgångsrikt

3. programmet startar om vackert och laddar

-listan4. Listan kan inte laddas om (om) utan ett MemoryError

Alla tips (andra än specifika) – spara inte majoriteten av dessa filer

Girigt innehåll för checklistan! Även om detta är ett enkelt “svar” får jag en glimt av under

prick ).

You Have A Problem With Python Pickle Dump Memory Error

Prendi Un Problema Con L’errore Di Memoria Ram Python Pickle Dump

Sie Haben Weiterhin Ein Problem Mit Einem Python Pickle Dump-Speicherbereichsfehler

Je Hebt Een Probleem Met Python Pickle Dump Geheugenfout

Vous Avez Un Problème Avec L’erreur De Mémoire Python Pickle Dump

Você Tem Um Problema Com O Erro De Memória Python Pickle Dump

Python Pickle Dump 기억 오류에 문제가 있습니다.

У вас проблема с ошибкой памяти Python Pickle Dump

Masz Problemy Z Błędem Pamięci Python Pickle Dump

Tiene Un Peligro Con El Error De Memoria De Python Pickle Dump